CS 질문

개요

면접 질문들을 정리한 문서이다. 웹 개발, 시스템 / 네트워크 프로그래밍, 보안에 대한 면접 질문이 섞여 있어 필요한 부분만 찾아보는 것을 추천한다.

자세한 내용은 Ctrl + F 로 찾아보는 것을 권한다.

CS 질문

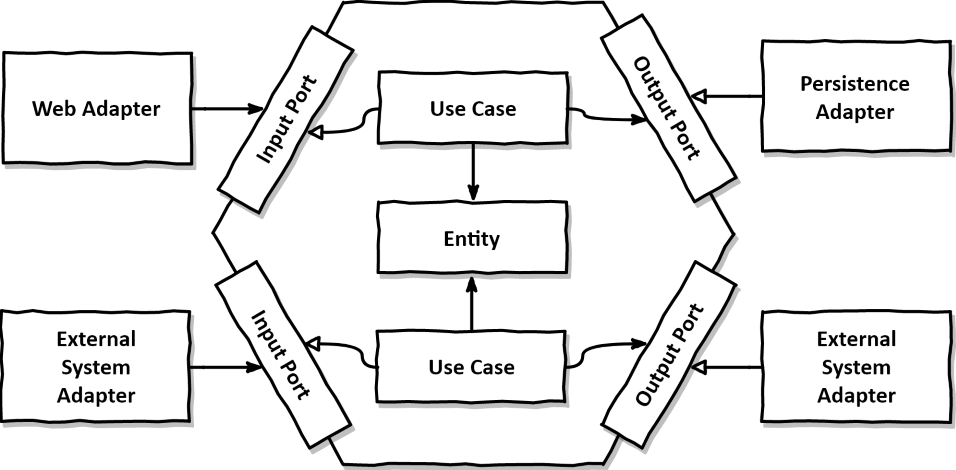

헥사고날 아키텍쳐

응용 프로그램의 비즈니스 로직을 외부 세계로부터 격리시켜 유연하고 테스트하기 쉬운 구조를 만드는 것 이를 위해 핵심 비즈니스 로직은 중앙의 도메인 영역에 위치하며, 입력과 출력을 처리하는 포트와 어댑터를 통해 외부와 소통합니다.

SOLID (객체 지향 설계의 5가지 원칙)

- S: Single Responsibility Principle (단일 책임 원칙)

- 하나의 클래스는 하나의 책임만 가져야 한다.

- O: Open/Closed Principle (개방-폐쇄 원칙)

- 확장에는 열려있고, 변경에는 닫혀있어야 한다.

- 기능이 변하거나 확장 가능하지만, 해당 기능의 코드는 수정하면 안 된다. (기능을 확장하기 위해 기존 코드의 수정이 필요하지 않는 것.)

- ex) JDBC: db 변경 시 connection 객체 부분만 변경해주면 된다.

- L: Liskov Substitution Principle (리스코프 치환 원칙)

- 자식 클래스는 부모 클래스를 대체할 수 있어야 한다.

- 부모 클래스의 행동 규약을 자식 클래스가 위반하면 안 된다.

- 부모 클래스의 인스턴스를 자식 클래스의 인스턴스로 대체해도 프로그램의 원래 동작에 영향을 주지 않아야 한다.

- 자식 클래스는 부모 클래스를 대체할 수 있어야 한다.

- I: Interface Segregation Principle (인터페이스 분리 원칙)

- 클라이언트는 자신이 사용하지 않는 인터페이스에 의존하지 않아야 한다.

- 하나의 큰 인터페이스보다는 여러 개의 작은 인터페이스로 나누어야 한다.

- D: Dependency Inversion Principle (의존성 역전 원칙 - DIP)

- 추상화에 의존해야 하고, 구체화에는 의존하지 말아야 한다.

- 구체화에 의존하면 변경이 어려워진다.

- 추상화에 의존하면 변경이 용이해진다.

- Spring Framework 및 각종 웹 프레임워크에서 의존성 역전 원칙이 적용되어 있다.

- 의존성 주입

- ex) 개발자가 비즈니스 로직을 상세하게 구현 (구체화) 한 뒤, 웹 프레임워크에서 제공한 추상화 인터페이스에 연결해 의존성을 주입한다.

- 의존성 주입

디자인 패턴

경력직 한정 각 디자인 패턴을 어느정도는 알고 있어야 한다.

각 패턴을 하나하나 상세히 설명하면, 내용이 매우 길어지므로 간략한 설명으로 대체한다. 디자인 패턴의 경우, 3~5줄 정도의 매우 단순한 예제코드로는 표현할 수 조차 없고, 특정한 상황을 직접 겪어 보거나 예제 코드를 직접 작성해보지 않으면 이해하기 어렵기 때문에 다른 책이나 온라인 자료를 참고하는 것을 추천한다.

(행구생)

- 생성 패턴

-

싱글톤 (Singleton)

- 하나의 클래스 인스턴스를 전역에서 접근 가능하게 하면서 해당 인스턴스가 한 번만 생성되도록 보장하는 패턴

-

팩토리 메서드 (Factory Method)

- 객체를 생성하기 위한 인터페이스를 정의하고, 서브클래스에서 어떤 클래스의 인스턴스를 생성할지 결정

- 추상 팩토리 (Abstract Factory)

- 관련된 객체들의 집합을 생성하는 인터페이스를 제공하며, 구체적인 팩토리 클래스를 통해 객체 생성을 추상화하는 패턴

-

빌더 (Builder)

- 복잡한 객체의 생성 과정을 단순화하고, 객체를 단계적으로 생성하며 구성하는 패턴

- 프로토타입 (Prototype)

- 객체를 복제하여 새로운 객체를 생성하는 패턴으로, 기존 객체를 템플릿으로 사용하는 패턴

-

싱글톤 (Singleton)

- 구조 패턴

- 어댑터 (Adapter)

- 인터페이스 호환성을 제공하지 않는 클래스를 사용하기 위해 래퍼(Wrapper)를 제공하는 패턴

- 브리지 (Bridge)

- 추상화와 구현을 분리하여 두 가지를 독립적으로 확장할 수 있는 패턴

- 컴포지트 (Composite)

- 개별 객체와 복합 객체를 동일하게 다루어, 트리 구조의 객체를 구성하는 패턴

- 데코레이터 (Decorator)

- 객체에 동적으로 새로운 기능을 추가하여 객체를 확장할 수 있는 패턴

- 퍼사드 (Facade)

- 서브시스템을 더 쉽게 사용할 수 있도록 단순한 인터페이스를 제공하는 패턴

- 플라이웨이트 (Flyweight)

- 공유 가능한 객체를 통해 메모리 사용을 최적화하는 패턴

- 프록시 (Proxy)

- 다른 객체에 대한 대리자(Proxy)를 제공하여 접근 제어, 지연 로딩 등을 구현하는 패턴

- 어댑터 (Adapter)

- 행위 패턴

- 책임 연쇄 (Chain of Responsibility)

- 요청을 보내는 객체와 이를 처리하는 객체를 분리하여, 다양한 처리자 중 하나가 요청을 처리하는 패턴

- 커맨드 (Command)

- 요청을 객체로 캡슐화하여 요청을 매개변수화 하고, 요청을 큐에 저장하거나 로깅하고 실행을 지연시키는 패턴

- 옵저버 (Observer)

- 객체 간의 일대다 종속 관계를 정의하여 한 객체의 상태 변경이 다른 객체들에게 알려지도록 하는 패턴

- 인터프리터 (Interpreter)

- 언어나 문법에 대한 해석기를 제공하여, 주어진 언어로 표현된 문제를 해결하는 패턴

- 방문자 (Visitor)

- 객체 구조를 순회하면서 다양한 연산을 수행하게 만드는 패턴

- 중재자 (Mediator)

- 객체 간의 상호 작용을 캡슐화하여, 객체 간의 직접적인 통신을 방지하는 패턴

-

반복자 (Iterator - 이터레이터)

- 컬렉션 내의 요소들에 접근하는 방법을 표준화하여 컬렉션의 내부 구조에 독립적으로 접근할 수 있는 패턴 (C++의 Iterator)

-

전략 (Strategy)

- 알고리즘을 정의하고, 실행 중에 선택할 수 있게 하는 패턴

- 상태 (State)

- 객체의 상태를 캡슐화하고, 상태 전환을 관리하는 패턴

-

템플릿 메서드 (Template Method)

- 알고리즘의 구조를 정의하면서 하위 클래스에서 각 단계의 구현을 제공하는 디자인 패턴

- 메멘토 (Memento)

- 객체의 내부 상태를 저장하고 복원할 수 있는 기능을 제공하는 패턴

- 책임 연쇄 (Chain of Responsibility)

출처: https://ittrue.tistory.com/550

설계 질문

동시성 처리

웹 백엔드 질문 MSA (Micro Service Architecture) 에서 아래 동시성 문제를 처리할 수 있는 방법이나 설계에 대해 고민해 볼 것.

- 따닥 문제 (중복 호출 문제)

- API가 중복으로 호출되었을 경우에 대한 처리

- ex) 결제 API가 두 번 호출되어 사용자는 결제 버튼을 한번 눌렀지만 두 번 결제됨.

- ex) 결제 버튼을 매우 빠른 시간안에 따닥 하고 두번 (더블클릭) 하자, 두 번 결제됨.

- 프론트에서 물론 막을 수 있겠지만, 버그가 발생하거나 특정 상황에서 API가 두 번 호출될 수 있는 문제를 해결해야 한다.

- 예시: (사용자가 결제 도중 뒤로가기를 눌렀다가 다시 결제 페이지로 오는 경우는 막을 수 없음.)

- 근본적인 설계 등의 변경으로 해당 상황의 완전 방지가 필요함.

- https://blog.wadiz.kr/%EB%B6%84%EC%82%B0-%ED%99%98%EA%B2%BD-%EC%86%8D%EC%97%90%EC%84%9C-%EB%94%B0%EB%8B%A5%EC%9D%84-%EC%99%B8%EC%B9%98%EB%8B%A4/

- API가 중복으로 호출되었을 경우에 대한 처리

- 선착순 문제

- 선착순 이벤트(선착순 100명 버튼)을 개발하는 방법 (이 때, 사용자가 매우 많이 몰린다고 가정한다.)

- ex) 쿠폰 발급 선착순 이벤트 100명 중 99명이 완료된 상태. 이후 1명이 남은 상태에서 2명이 동일한 시각에 쿠폰발급 버튼을 눌렀다.

- 요청한 2명 모두에게 쿠폰을 발급할 수 없다. (쿠폰은 정확히 100개로, 101개 또는 그 이상의 개수를 발급할 수 없는 상황)

캐시 처리 질문

- 캐시 관통

- 데이터베이스에서 읽었는데도 캐싱 되지 않는 상황

- 보통 DB에 값이 없을 때 null을 받아오면 캐시를 채우지 않도록 구현하는데, ‘값이 없다’ 라는 정보를 캐싱하지 않으면 계속 불필요한 요청을 하게된다.

- https://toss.tech/article/cache-traffic-tip

- 해결방법: 널 오브젝트 패턴 (Null Object Pattern)

- 이 객체를 대체할 특정 값을 지정해야 한다.

- 예를 들어 양수만 존재하는 정수 타입의 데이터를 캐시해야하는 경우, 음수의 정수인 최소값으로 ‘값이 없음’을 나타내기로 애플리케이션에서 약속할 수 있다.

- 캐시 쇄도

- 캐시가 전부 같은 시간에 만료되도록 하면 발생하는 이슈

- 해결 방법

- 지터(jitter): 캐시 만료 시간에 0~10초 사이의 무작위 지연 시간을 추가하여 설정

- 캐시 시스템 장애

- 트래픽이 큰 상황에서 캐시 시스템이 장애가 날 경우 복구 되기 전까지 DB에 과부하가 걸릴 수 있다.

- 해결방법: 대체 작동 (Failover - 이중화 설계에 대해 더욱 자세히 설명함.)

- 현실적으로 반드시 동작해야하는 핵심 기능을 제외하고 부가 기능은 운영을 중단하는게 옳다.

- 핫키 만료

- 핫키: 많은 요청이 집중되는키

- 핫키가 만료되는 순간 여러 요청이 동시에 DB를 조회하게 된다. 캐시 만료기한을 없애거나 주기적으로 새값을 적용해서 만료되지 않도록 하는 것이 좋다. 하지만 핫키가 아닌 데이터로 인해 캐시 저장소가 낭비될 수 있다.

- 해결 방법: 분산락(Distributed Lock)

- 멀티 스레드 프로그래밍에서 공유 자원을 다룰 때 락을 사용하는 것과 비슷한 원리.

- 캐시 미스가 발생했을 때 락을 설정하고 캐싱한 후에 락을 해제함으로써 단 한번의 쓰기 작업만 허용할 수 있다.

- Redis 를 사용한다면 적용하기 쉽다. (레드락 알고리즘)

단일 장애 지점 (SPOF - Single Point of Failure)

- 코드 레벨의 SPOF

- 원인: 과도한 의존성 문제

- 특정 외부 서비스나 API에 의존할 경우, 애플리케이션의 중요 기능이 중단될 위험이 있다. 특히 결체 처리나 사용자 인증과 같은 핵심 기능을 담당하는 외부서비스에 이런 위험이 크다

- 해결 방안

- 외부 서비스에 대한 타임 아웃 호출에 대한 타임 아웃 설정을 하거나, 서킷 브레이커 패턴을 사용해서 서비스 장애 시 자동으로 대체 서비스로 전환되도록 구상한다. 이는 장애 발생 시 즉시 대응할 수 있게 해 준다. 또한 한 서비스만에 만 의존하는 대신 여러 서비스 제공자를 사용함으로써 의존성을 분산시킨다.

- 서킷 브레이커 패턴

- 다른 서비스에 장애가 발생하였는데도 계속 요청을 주어 장애 복구를 힘들게 만드는 상황을 방지하고자, 장애가 발생한 서비스를 탐지하고 요청을 보내지 않도록 차단하는 것. 즉, 실패할 수 있는 작업을 계속 시도하지 않도록 방지한다 만약 계속 장애가 나는 서비스를 요청하면 타임아웃만큼 대기시간이 생기고 스레드와 메모리 등 CPU의 자원을 점유하여 결국 시스템 리소스를 부족하게 만들어 장애를 유발할 수 있다. Java 진영의 서킷 브레이커 라이브러리로는 Resilence4J라는 것이 대표적이다.

- 단일 데이터베이스의 SPOF

- 원인: 하나의 데이터베이스에 의존 -> 해당 데이터베이스가 장애

- 하나의 데이터베이스에 의존하게 되면 서버 장애 시 데이터 처리가 중단되고 전체 시스템에 영향을 준다.

- 해결 방안: 여러 해결책이 있는데 대표적으로 레플리케이션, 샤딩, 클러스터링이 있다.

- 레플리케이션, 샤딩, 클러스터링은 밑에서 설명

- 클러스터링은 Redis의 redis 클러스터링이 대표적이다. (master-slave 구조를 참고한다.)

- 레플리케이션, 샤딩, 클러스터링은 밑에서 설명

- 서버 SPOF

- 원인: 하나의 서버에 의존 -> 해당 서버가 장애

- 하나의 서버에 의존하게 되면 서버 장애 시 서비스 제공이 어렵다.

- 해결 방법: 서버를 여러 대 띄워 1번 서버 장애 시 2번 서버가 처리를 진행하는 등 이중화나 FailOver 구성 로드밸런서 등과 함께 이용하여 부하분산을 할 수 있다.

이중화 (HA - High Availability) & 백업 (Backup)

- Active / Standby (FailOver)

실제 동작하는 서버와 예비용 서버 (장애를 대비한 서버) 를 둔다. 일반적인 환경에서는 Active (실제 동작 중인 장비) 가 동작한다. 해당 서버가 장애 시 Standby 서버가 Active 서버로 전환된다.

- Active / Active

동작하는 서버를 두 대 준비하여 해당 두 서버가 모두 동시에 요청을 처리한다. 이 때, 두 서버는 동일한 데이터를 가지고 있어야 하는 등 동기화나 데이터 일관성 문제 등 여러 문제가 발생할 수 있어, 많이 사용되지는 않는다.

- 하드웨어의 이중화

- 디스크 이중화

- 네트워크 이중화 …

- DB 이중화

- 백업 방법

로그와 모니터링

- 로그의 수집과 관리, 분석 방법

- 사례: 사용자들의 로그를 수집해 발빠른 이슈 분석, 장애 상황 대응, 특정 시간의 부하율, 사용자의 행동 패턴을 파악해 서비스 성능 향상시키고, 노출 알고리즘을 최적화하여 광고 수익 향상 등

- 위와 같은 사례 등으로 인해 로그의 수집, 관리, 분석이 중요해졌다.

- 큰 규모의 서비스 제공자는 초당 GB, TB 수준의 로그가 모이는 경우가 많다. 이러한 로그를 처리할 수 있게끔 시스템을 설계하는 방안을 고민해 볼 것.

- 모니터링 서비스 및 환경 구축 (DataDog)

- DataDog는 로그 수집, 분석, 모니터링 서비스를 제공한다.

- 부하나 트래픽 몰림 현상 발생 시 자동으로 AutoScale 등을 진행하는 환경 구축 방안을 고민해 볼 것.

- observability (관찰 가능성)에 대한 인사이트

- 시스템의 내부 상태를 외부에서 관찰할 수 있는 능력

우리가 만든 시스템이 지금 어떤 상태인지, 뭔가 문제가 생겼을 때 왜 그런 문제가 발생했는지를 파악할 수 있는 정도

- 3가지 기둥

- 로그 (Logs)

- 시스템에서 발생하는 이벤트들의 기록

- 언제, 무엇이, 어떻게 일어났는지 알려줌

- 디버깅할 때 가장 기본적으로 확인하는 정보

- 메트릭 (Metrics)

- 시스템의 성능, 지표를 숫자로 표현

- CPU 사용률, 메모리 사용량, 응답 시간 등

- 시간에 따른 변화를 추적

- 트레이스 (Traces)

- 하나의 요청이 시스템을 통과하는 전체 경로를 추적

- 마이크로서비스 환경에서 특히 중요

- 어디에서 병목이 발생했는지 파악 가능

- 로그 (Logs)

- 모니터링 vs 관찰가능성

- 모니터링

- “뭔가 잘못되었다.” 라는 것을 알려주는 것

- 관찰 가능성

- “왜 잘못되었는가?” 를 파악할 수 있게 해주는 것.

- “어디서, 언제, 왜” 명확하게 알 수 있음.

- 모니터링

- 왜 중요한가?

- 빠른 문제 해결

- 장애 발생 시, 원인을 빠르게 찾을 수 있음.

- 성능 최적화

- 시스템의 병목 지점을 정확히 파악

- 사용자 경험 개선

- 실제 사용자가 경험하는 문제들을 이해

- 예방적 대응

- 문제가 커지기 전에 미리 감지

- 빠른 문제 해결

Auto Scale

급작스런 부하 발생 시, 이를 처리할 수 있는 설계에 대해 고민해 볼 것.

- Scale Up

- 서버의 성능을 높이는 것

- 더 빠른 CPU, 더 큰 메모리, 더 빠른 디스크 등을 사용하는 것

- Scale Out

- 서버의 수를 늘리는 것

- 더 많은 서버를 사용하여 부하를 분산하는 것

- 클라우드 환경에서 부하 분산을 위해 자주 사용되는 방법

배포

- 무중단 배포

- 서비스를 중단하지 않고 업데이트 하는 설계

- Jenkins

- Github Actions

TDD (Test Driven Development)

- 테스트 주도 개발

- 테스트 코드를 먼저 작성하고, 테스트를 통과하는 코드를 작성하는 방식

- 유닛 테스트 (Unit Test) 의 중요성

TDD의 개념을 모른다면, “테스트 주도 개발 (켄트 벡)” (Test-Driven Development By Example - Kent Beck) 책을 읽어볼 것.

- 유닛 테스트가 탄탄하다면, 코드 신뢰도를 높이고 리팩토링에 대한 부담을 줄일 수 있다. (리팩토링으로 인한 사이드이펙트)

개발 방법론

개발 방법론과 협업에 대한 질문이 많이 나온다. (특히 협업의 경우, 사람 대 사람으로 인해 발생하는 문제가 많이 발생하기 때문에, 인문학적 지식이 많을수록 좋다.)

- 기존 개발방법론

- 폭포수 모델

- V 모델

- 프로토타입 모델

- 나선형 모델 등

- 애자일 개발 방법론 (애자일적 방법론 - Agile)

- 스크럼과 스프린트

- XP (Extreme Programming)

- 페어 프로그래밍

-

코드 리뷰에 대한 질문 (협업 관련 질문 무조건 함.)

- 코드 리뷰 어떻게 했는지?

- 협업이나 코드 리뷰 하면서 불편한 점이나 마찰이 발생할 경우 어떻게 해결했는지

- 특정인이 개발한 로직에서의 버그로 인해 “너의(Your) 잘못이야.” 라고 단정짓는 것이 아닌, “팀의(Our) 잘못.” 이라는 생각과, 재발 방지를 위한 회고 등이 필요.

- 회고 내용 예시

- 코드 리뷰나 코드 상에서의 버그를 사전에 예방할 수는 없는지.

- 방어적 프로그래밍 (방어 운전에서 따옴)

- 객체 지향 설계의 원칙 (SOLID) 과 디자인 패턴

- 사이드이펙트 발생 시: 유닛 테스트와 같은 코드 안정성 검증

- 관찰가능성, 이슈가 발생했을 때의 빠른 이슈 파악을 위한 여러 방법을 고민해볼 것.

- 특정인에게 책임을 묻지 않는 문화가 중요하다고 생각함.

- 특정인에게 책임을 묻게 되는 순간, 코드 수정이나 리팩토링에 꺼려지게 되고, 이로 인해 기술 부채가 쌓일 수 있다.

- 코드 리뷰나 코드 상에서의 버그를 사전에 예방할 수는 없는지.

- 나의 단점 (협업에서)

- 예시 답변

- 직설적으로 말함. -> 최대한 순화해서 말하려고 노력함.

- 딱딱한 표정. -> 리뷰 시 최대한 입꼬리를 올리며 웃는 상을 유지하려고 노력함.

- 예시 답변

히스토리 관리와 문서화

형상 관리 도구 (Version Control System), 특히 Git에 대한 철저한 사용법을 익힐 것.

많이 쓰이는 명령어

- git init

- git clone

- git add

- git commit

- git push

- git pull

- git fetch

- git merge

- git rebase

- git stash

- git cherry-pick

- git checkout

- git reset

- git revert

- git tag

- git branch

git remote

- Git의 로컬 저장소와 원격 저장소

- fetch와 pull의 차이

- Git의 merge와 rebase의 차이

- ff (fast-forward) 머지에 대해서도 알아볼 것

- 현재 브랜치의 HEAD가 대상 브랜치의 HEAD까지로 옮기는 merge

- 브랜치 전략이 머지 전략인가? 아니면 리베이스 전략인가? 에 따라 나뉘므로 merge와 rebase는 구분이 필요하다.

- ff (fast-forward) 머지에 대해서도 알아볼 것

- Git

- Git의 브랜치 전략 등

- release 브랜치와 develop 브랜치를 분리하여 개발

- 특정 기능 개발 시, feature 브랜치에서 개발 후, develop 브랜치로 머지

- develop 브랜치에서 테스트 후, release 브랜치로 머지

- release 브랜치와 develop 브랜치를 분리하여 개발

- Git을 통한 개발 프로세스 등

- 예시 (일반적인 개발 프로세스)

- Github의 Issue 창에 사용자가 Issue를 등록

- 개발자가 해당 tag 또는 버전에서 이슈를 재현

- 현재 최신 릴리즈 (release 브랜치) 또는 develop 버전 (develop 브랜치) 에서 이슈 재현 확인

- 이슈 재현 확인 후, 해당 이슈를 수정 (feature 브랜치)

- 수정 후 테스트하여 Pull Request를 생성해 develop 브랜치로 머지 요청

- 코드리뷰와 여러 사람의 검증 후 develop으로 최종 머지

- release 항목 산정 후 버그 또는 기능을 develop에서 release 브랜치로 머지

- 모든 작업이 완료되면, release 브랜치를 최종 배포하고 브랜치를 tag로 추가한 뒤 버전을 기입.

- 예시 (일반적인 개발 프로세스)

- Git의 브랜치 전략 등

- Github

- Github의 Issue / Pull Request (Gitlab의 Merge Request) 등

- 이슈 관리 툴

- Jira

1px은 몇 비트인가

#ffffff (255,255,255) 로 24비트 (3byte) 이다.

흑백 이미지는 0~255 로 값을 표현하기 때문에 1byte만을 필요로 한다.

jpg, png의 차이점

- png는 투명도를 표현할 수 있고, jpg는 투명도를 표현할 수 없다.

- png는 무손실 압축 방법을 사용하고, jpg는 손실 압축 방법을 사용한다. (이러한 손실 압축으로 인해 디지털 풍화가 발생할 수 있음.)

이미지 보간법이란?

이미지에 변형을 줄 때 픽셀과 픽셀 사이의 값을 채워주는 것

- 이미지의 크기를 키우거나 (리사이징) 등

- 최근접 보간법

- 주변값에 가장 가까운 값으로 채워주는 방식이다

- 이중선형보간법

- 3차원 스플라인 보간법

HTTP/2의 HPack 알고리즘에 대해 설명해보세요.

- Huffman coding(혹은 Huffman code)을 활용한다

- 무손실 압축 알고리즘으로, 심볼의 출현 빈도를 기준으로 코드를 부여해 출현 빈도 수를 가지고 압축한다.

- 따라서 HTTP의 헤더 데이터와 같이 출현 빈도가 높은 데이터는 더 짧은 코드를 부여받아 압축률이 높다.

DB의 인덱스란?

- 인덱스 (B+트리)

CREATE INDEX idx_name ON table_name (column_name1, …); CREATE UNIQUE INDEX idx_name ON table_name (column_name1, column_name2, …);

- 인덱스를 찾는 것은 B+트리와 바이너리 서치를 사용한다.

- column_name1 을 먼저 정렬해 찾고, column_name2 를 정렬해 찾는다.

- 따라서 멀티 컬럼 인덱스(multicolumn index)는 컬럼 순서를 정하는 것이 중요하다.

- 조회를 하는 것은 상당히 빠르나, B+트리를 만들고 정렬해야 하기 때문에 삽입/삭제 등에는 오버헤드가 크다.

- table에 write 할 때 마다 index도 변경 발생

- 추가적인 저장 공간 차지

- 따라서 불필요한 인덱스를 만들지 말자.

- Covering Index

- 인덱스 컬럼을 포함하는 인덱스

- 인덱스 컬럼을 포함하는 인덱스를 사용하면 조회 속도가 빠르다.

- ex ) USER 테이블에

id,name,email,phone,address컬럼이 있을 때,id,name을 인덱스로 설정했다.- 조회 시 인덱스에 설정 된

id,name컬럼을 조회할 경우, 인덱스에 있는 컬럼들로 covering이 가능하기 때문에 테이블을 참조 할 필요가 없어 조회 속도가 더 빠르다.

- 조회 시 인덱스에 설정 된

- Hash Index

- 해시 테이블을 사용해서 인덱스를 구현함

- 조회 시간복잡도가 O(1) 이라서 빠르다.

- rehashing에 대한 부담이 존재.

- rehashing 이란?

- 해시 테이블의 크기를 조정하는 것

- 데이터가 많아져 여유 공간이 줄어들수록 해시 충돌이 자주 발생하며 탐색의 효율이 떨어지므로 이를 해결할 필요가 있다. 재해싱은 이러한 문제를 해결하는 방법 중 하나로, 해시 테이블의 크기를 늘리고 늘어난 해시 테이블의 크기에 맞춰 테이블 내의 모든 데이터를 다시 해싱

- rehashing 이란?

- 해시다 보니 equality(=) 비교만 가능, range(>, <, >=, <=) 비교는 불가능하다.

- multicolumn index의 경우, attributes 에 대한 조회만 가능하다.

- Full scan이 더 좋은 경우

- table에 대한 데이터가 조금 있을 때 (몇십 몇백건 정도?)

- 조회하려는 데이터가 테이블의 상당 부분을 차지할 때

SELECT * FROM player WHERE mobile_carrier = 'SKT';- mobile_carrier 칼럼에서 SKT 데이터로 인한 출력 값이 막 100만건 이상 출력되는 등 조회 데이터가 많을 때

- order by나 group by 에도 index가 사용될 수 있다.

- foreign key에는 index가 자동으로 생성되지 않을 수 있다. (join 관련)

이미 데이터가 몇 백만건 이상 있는 테이블에 인덱스를 생성하는 경우, 시간이 몇 분 이상 소요될 수 있고 DB 성능에 안좋은 영향을 끼칠 수 있다.

- 인덱스는 기본적으로 RDBMS Optimizer(RDBMS마다 다를 수 있음.)가 기본적으로 알맞게 지정해서 사용한다.

- 인덱스 권장

SELECT * FROM player USE INDEX (idx_name) WHERE column_name1 = 'value1' AND column_name2 = 'value2';

- 인덱스 반강제 (사용하지 못할 경우에는 사용 안함.)

SELECT * FROM player FORCE INDEX (idx_name) WHERE column_name1 = 'value1' AND column_name2 = 'value2';

- 인덱스 제외

SELECT * FROM player IGNORE INDEX (idx_name) WHERE column_name1 = 'value1' AND column_name2 = 'value2';

- select, join

- 쿼리 최적화 / 쿼리 튜닝

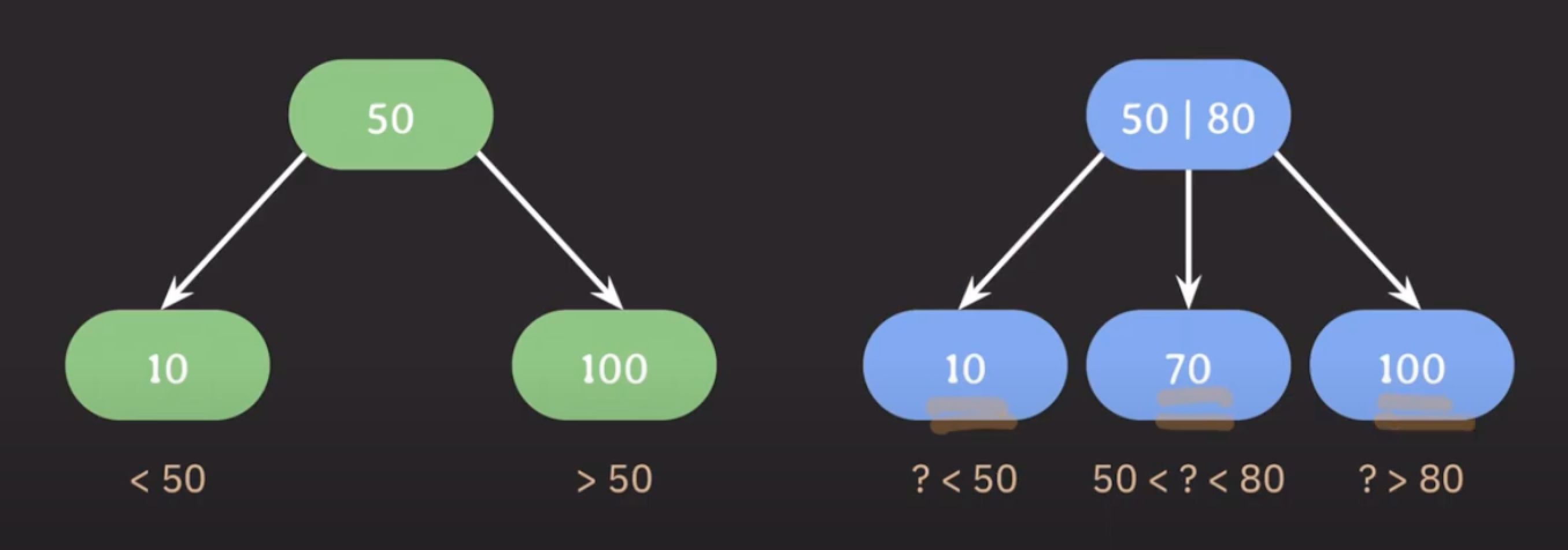

B Tree / B+ Tree

- 이진 탐색 트리 : 왼쪽은 부모 노드보다 작은 값을, 오른쪽은 부모 노드보다 큰 값을 가진다.

- B Tree는 이진 탐색 트리의 확장판이다.

- 자녀 노드의 최대 개수를 늘리기 위해서 부모 노드에 key를 하나 이상 저장한다.

- 부모 노드의 key들을 오름차순으로 정렬한다.

- 정렬된 순서에 따라 자녀 노드들의 key 값의 범위가 결정된다.

-> 이런 방식을 사용하면 자녀 노드의 최대 개수를 입맛에 맞게 결정해서 쓸 수 있다 -> B Tree 는 BST를 일반화한 트리!

- 최대 몇 개의 자녀 노드를 가질 것인지가 B tree를 사용할 때 중요한 파라미터

-

M: 각 노드의 최대 자녀 수- 최대

M개의 자녀 노드를 가질 수 있는 B tree를M차 B tree라고 한다.

- 최대

-

M-1: 각 노드의 최대 key 수-

M값이 결정되면 자동으로 결정되는 값

-

-

⌈M/2⌉: 각 노드의 최소 자녀 수 (홀수가 나올 경우 값을 올림)- 루트(root), 리프(leaf) 노드는 제외된다.

-

⌈M/2⌉-1: 각 노드의 최소 key 수- 루트(root) 노드는 제외됨.

-

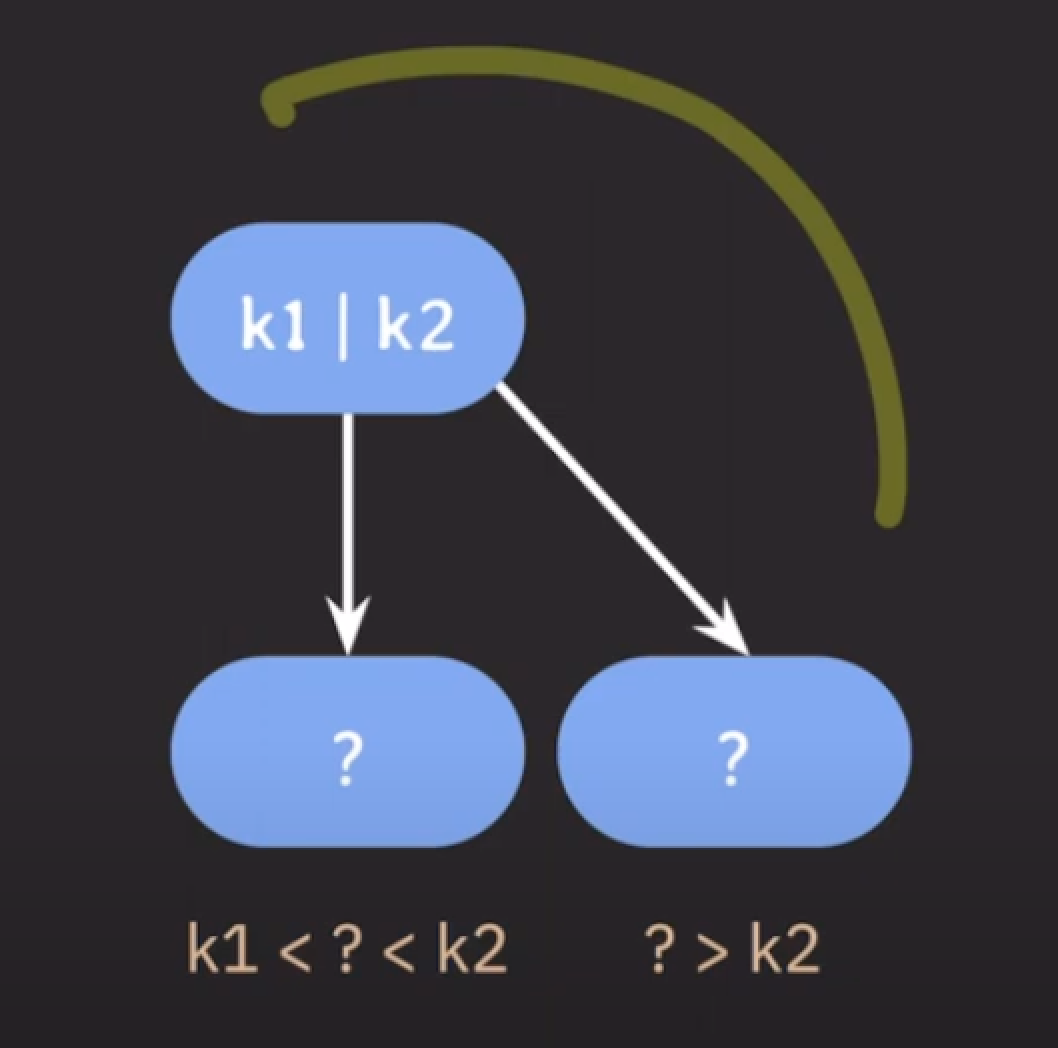

- internal node의 key 수가 x개라면, 자녀 노드의 수는 언제나 x+1개 이다.

- 노드가 최소 하나의 key는 가지기 때문에 몇 차 B tree 인지와 상관없이 internal 노드는 최소 두 개의 자녀는 가진다.

-

M이 정해지면 root 노드를 제외하고 internal 노드는 최소⌈M/2⌉개의 자녀 노드를 가질 수 있게 된다.

-

B Tree 데이터 삽입

- 추가는 항상 리프(leaf) 노드에서 이루어진다.

- 노드가 넘치면 가운데(median) key를 기준으로 좌우 key들은 분할하고, 가운데 key는 승진한다. (부모 노드로 옮긴다.)

-

https://www.youtube.com/watch?v=bqkcoSm_rCs

17:00참고 - 모든 리프 노드들은 같은 레벨에 있다. (B Tree의 특징)

- B Tree는 Balanced Tree (자가 균형 트리) 이다.

- 검색 avg/worst case

O(logN)

- B Tree (B+ Tree, B* Tree)

- avg/worst case에 대해 조회/삽입/삭제 모두

O(logN)을 보장한다.

- avg/worst case에 대해 조회/삽입/삭제 모두

- self-balancing BST

- 하지만 self-balanceing BST 또한 시간 복잡도가 B Tree와 같다.

- AVL Tree

- avg/worst =

O(logN)

- avg/worst =

- Red-Black Tree

- avg/worst =

O(logN)

- avg/worst =

- RAM : 평균 속도 40~50GB/s

- SSD : 3 ~ 5GB/s

HDD : 0.2~0.3GB/s

- Secondary Storage

- Block 단위로 데이터를 읽고 쓴다.

- 불필요한 데이터까지 읽어올 가능성이 있다.

- Block 단위로 데이터를 읽고 쓴다.

- DB에서 데이터를 조회할 때, Secondary Storage에 최대한 적게 접근하는 것이 성능 면에서 좋다.

- Block 단위로 읽고 쓰기 때문에 연관된 데이터를 모아서 저장하면 더 효율적으로 읽고 쓸 수 있다.

BTree는 데이터(key)를 모아서(연관되어) 저장하기 때문에 데이터를 조회할 때 더 효율적으로 읽을 수 있다.

- 101차 B Tree의 경우 네 게의 level 만으로 수백만, 수천만 개의 데이터를 저장할 수 있다.

- root 노드에서 가장 멀리 있는 데이터도 세 번의 이동만으로 접근할 수 있다.

- DB는 기본적으로 secondary storage에 저장된다.

- B tree index는 self-balancing BST 에 비해 secondary storage에 접근하는 횟수가 적다.

B tree 노드는 block 단위의 저장 공간을 알차게 사용할 수 있다.

- hash index는 삽입/삭제/조회의 시간 복잡도가 O(1) 이지만 equality(=) 조회만 가능하고, 범위 기반 검색이나 정렬에는 사용될 수 없다는 단점이 있다.

정규화

- 데이터 중복과 isertion, update, deletion anomaly를 최소화하기 위해 일련의 normal forms (NF)에 따라 relational DB를 구성하는 과정

Normal Forms

정규화되기 위해 준수해야 하는 몇 가지 rule들이 있는데 이 각각의 rule을 normal form(NF) 이라고 부른다.

- FD와 key 만으로 정의되는 normal forms

- 3NF 까지 도달하면 정규화 되었다고 말하기도 함.

보통 실무에서는 3NF 혹은 BCNF 까지 진행 (많이 해도 4NF 정도까지만 진행)

- super key : 테이블에서 tuple들을 unique 하게 식별할 수 있는 attributes set

- (candidate) key : 어느 한 attribute 라도 제거하면 unique 하게 tuples를 식별할 수 없는 super key

- {account_id} - 슈퍼키, {bank_name, account_num} - 후보키이면서 슈퍼키

- primary key : table에서 tuple들을 unique 하게 식별하려고 선택된 (candidate) key

- {account_id}

- prime attribute : 임의의 key에 속하는 attribute

- account_id, bank_name, account_num

- non-prime attribute : 어떠한 key에도 속하지 않는 attribute

정규화 과정

도부이결다조

- 제 1 정규화

- 도메인을 원자값으로

- 제 2 졍규화

- 부분 종속을 제거

- 기본 키 중 일부 키에만 종속되는 값이 없어야 한다.

- 제1 정규형을 만족한 테이블에 대해서 완전 함수 종속을 만족하도록 테이블을 분리하는 것

- 부분 종속을 제거

- 제 3 정규화

- 이행 종속을 제거

- 이행적 종속이란 A->B, B->C가 성립할 때 A->C가 성립되는 것을 의미한다.

- 제2 정규화를 진행한 테이블에 대해 이행적 종속을 없애도록 테이블을 분해하는 것이다.

- 이행 종속을 제거

- BCNF

- 모든 결정자가 후보키가 되도록 테이블을 분리

- 결정자가 후보키가 아닌 함수 종속을 제거한다.

- 모든 결정자가 후보키가 되도록 테이블을 분리

- 제 4 정규화

- 다중 값(다치) 종속을 제거

- 다치 종속이란?

- 같은 테이블 내의 독립적인 두 개 이상의 컬럼이 또 다른 컬럼에 종속되는 것을 말한다.

- 즉, A → B 인 의존성에서 단일 값 A와 다중 값 B가 존재한다면 다치 종속이라고 할 수 있다. 이러한 종속을 A ↠ B 로 표기한다. (다치 종속은 이중 화살표(double arrow) ↠ 로 표기한다.)

- 다치 종속은 최소 2개의 컬럼이 다른 컬럼에 종속되어야 하기 때문에 최소 3개의 컬럼이 필요하다.

- 다치 종속이란?

- 다중 값(다치) 종속을 제거

- 제 5 정규화

- 조인 종속을 제거

- 조인 종속이란?

- 하나의 릴레이션을 여러개의 릴레이션으로 분해하였다가, 다시 조인했을 때 데이터 손실이 없고 필요없는 데이터가 생기는 것을 말한다.

- 조인 종속성은 다치 종속의 개념을 더 일반화한 것이다.

- 더 이상 비손실 분해를 할 수 없어야 한다.

- 조인 종속이란?

- 조인 종속을 제거

제 6 정규화

- 반정규화

- 데이터베이스의 성능 향상을 위하여, 데이터 중복을 허용하고 조인을 줄이는 데이터베이스 성능 향상 방법

DBCP (DataBase Connection Pool - 커넥션 풀)

- 일반적으로 DB의 내용이 필요할 때 마다 TCP 커넥션을 맺고 끊으면 비용이 많이 든다.

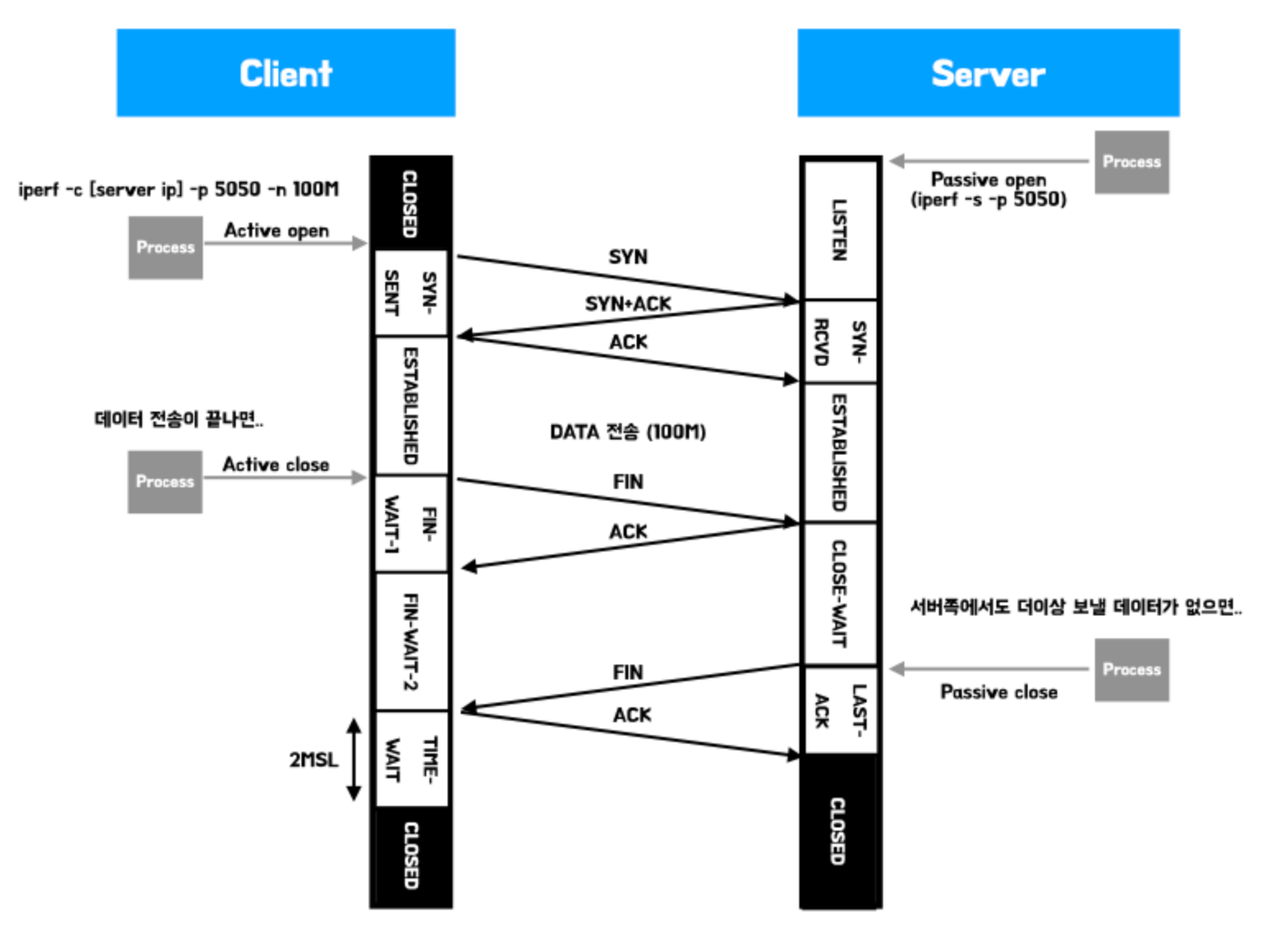

- 3way handshake / 4way handshake 등, 매번 커넥션을 열고 닫는 과정을 거쳐야 하기 때문이다.

- 따라서 커넥션을 미리 맺어두고 필요할 때 마다 사용하여 이러한 비용을 줄일 수 있다.

- connection을 재사용하여 열고 닫는 시간을 절약시킬 수 있다.

- 이를 DataBase Connection Pool이라고 부른다.

- 아래 설명되는 내용은 Spring Boot의 HikariCP, Mysql 의 예시를 설명한다.

- DB Connection은 backend server와 DB server 사이의 연결을 의미하기 때문에, backend server와 DB 서버 각각에서의 설정(configure) 방법을 잘 알고 있어야 한다.

- MySQL에서는 중요한 두가지 파라메터가 있다.

- max_connections

- client와 맺을 수 있는 최대 커넥션 수

- 만약 max_connection 수가 4, DBCP의 최대 커넥션 수가 4라면?

- MSA에서, 만약 웹서버를 증설시킬 경우, 새로운 웹서버는 DB와 커넥션을 맺을 수 없다.

- (이미 기존 서버가 4개의 커넥션을 맺었기 때문에)

- wait_timeout

- connection이 inactive 할 때, 다시 요청이 오기까지 얼마의 시간을 기다린 뒤에 close 할 것인지를 결정하는 파라메터

- 비정상적인 상황을 방지하기 위해 사용된다.

- 비정상적인 connection 종료

- connnection을 다 쓰고 반환이 되지 않는 경우 (릭)

- 네트워크 단절

- 비정상적인 상황을 방지하기 위해 사용된다.

- connection이 inactive 할 때, 다시 요청이 오기까지 얼마의 시간을 기다린 뒤에 close 할 것인지를 결정하는 파라메터

- max_connections

- DBCP 설정 (HikariCP)

- minimumIdle과 maximumPoolSize는 값이 동일함.

- 그리고 이 값을 동일하게 설정하는 것을 권장함.

- 그 말인 즉슨, 커넥션 갯수를 고정하는 것이다.

- 커넥션을 맺는 것 자체가 시간과 비용이 걸리므로, 트래픽이 몰려올 때에서야 커넥션을 추가로 맺게 되면 비용이 발생할 수 있어 서버가 빠르게 대응하지 못할 수 있다.

- 그리고 이 값을 동일하게 설정하는 것을 권장함.

- minimumIdle

- pool에서 유지하는 최소한의 idle connection 수

- idle connection 수가 minimumIdle 보다 작고, 전체 connection 수도 maximumPoolSize 보다 작으면 신속하게 추가로 connection을 맺는다.

- maximumPoolSize

- pool이 가질 수 있는 최대 connection 수

- idle(유휴, 노는 커넥션)과 active(in-use) connection 합쳐서 최대 수

- maximumPoolSize가 minimumIdle 값 보다 우선순위가 높다.

- maxLifetime

- pool에서 connection의 최대 수명

- maxLifetime을 넘기면 idle일 경우 pool에서 바로 제거

- active인 경우 pool로 반환된 후 제거

- pool로 반환이 안되면, maxLifetime 동작 안함.

- 다 사용한 connection은 pool로 반환을 잘 시켜주는 것이 중요하다!

- DB의 connection time limit 보다 몇 초 짧게 설정해야 한다.

- 만약, DB의 wait_timeout이 60초, DBCP의 maxLifetime이 60초라면?

- 타이밍적인 이슈로 인해 서버와 DB가 통신하는 사이 커넥션이 끊어질 수 있다.

- 따라서 안전하게 maxLifetime을 몇 초 짧게 설정해야 한다.

- 만약, DB의 wait_timeout이 60초, DBCP의 maxLifetime이 60초라면?

- connectionTimeout

- pool에서 connection을 받기 위한 대기시간

- 만약 connectionTimeout이 30초라면?

- 부하가 발생하여 모든 커넥션을 사용한 상황에서 30초까지 대기하게 된다.

- 30초를 넘으면 timeout exception을 발생시킨다.

- 부하가 발생하여 모든 커넥션을 사용한 상황에서 30초까지 대기하게 된다.

- 일반적인 사용자로부터 오는 요청의 경우 30초도 너무 길다. (일반 사용자는 3~5초 대기하다가, 응답이 오지 않으면 새로고침하거나 나가는 등의 행동을 하기 때문.)

- 즉 connectionTimeout을 몇 초 정도로 줄 것인지 잘 생각해 보아야 한다.

- minimumIdle과 maximumPoolSize는 값이 동일함.

적절한 connection 수를 찾기 위한 과정

- 모니터링 환경 구축 (서버 리소스, 서버 스레드 수, DBCP 등등)

- 백엔드 시스템 부하 테스트

- nGrinder

- request per second, avg response time 확인

- RPS가 늘어나다가 어느 순간부터는 늘어나지 않음.

- ARPT도 똑같음.

- 이후 응답 시간이 계속 늘어남.

- 백엔드 서버, DB 서버의 CPU, MEM 등등 리소스 사용률 확인

- cpu, mem 등의 사용률이 급격히 치솟으면 웹서버 증설이 필요

- db 서버의 cpu, mem 사용률이 높으면?

- select 쿼리가 많을 경우 secondary 추가

- cache layer 추가

- sharding 추가 등등

- db 서버의 cpu mem 사용률도 높지 않은데… 응답 시간이 늘어난다면?

- thread per request 모델이라면 active thread 수 확인!

- 스레드 카운트가 너무 없어서 발생하는 문제일 수도 있음!

- thread pool 이 100개 인데 active thread 수가 50개면? 이것도 문제 없다.

- DBCP의 active connection 수를 확인

- maximumPoolSize 를 늘려서 확인

db의 max_connections 수도 늘려서 적절히 확인

- 사용할 백엔드 서버 수를 고려하여 DBCP의 max pool size를 결정

- 적당히 여유분이 있는 수치로 설정하는 것이 좋을듯

파티셔닝, 샤딩, 레플리케이션

https://youtu.be/P7LqaEO-nGU?si=uJeWNKBX2oGWek9P

파티셔닝

- database table을 더 작은 table들로 나누는 것

- table을 목적에 따라 작은 table들로 나누는 방식

- vertical partitioning (수직 분할)

- 컬럼(column)을 기준으로 나누는 것

- 정규화도 어떻게 보면 수직 분할 (vertical partitioning) 으로 볼 수 있다.

- ex ) 게시글에서 content(본문, 게시글 내용)의 경우 데이터가 많은데, 이를 따로 빼서 저장하는 것이다.

- 게시글을 게시글정보 테이블에 함께 저장할 경우, 인덱스 등을 사용하지 않고 Full Scan할 경우 유의미한 성능 저하가 발생할 수 있다.

- 테이블 조회 시, select로 특정 정보만 내가 가져오는 경우에도, 테이블의 모든 정보를 io에서 불러오기 때문이다.

- 이 경우, 게시글정보와 본문 정보를 따로 저장하여 수직분할 하는 것이 좋다.

- 그 외에도 민감한 정보 등을 따로 저장할 때 테이블을 분리하여 virtical partitioning을 사용한다.

- horizontal partitioning (수평 분할, 샤딩이랑 비슷함 - 그럼 샤딩은 왜함?)

- 레코드(row)를 기준으로 나누는 것

- hash function을 사용해서 레코드를 분할시킬 수 있다.

- ex ) 구독 서비스 정보를 저장할 때, 몇억, 몇십억 건의 데이터를 저장할 경우

- subscription_0, subscription_1, subscription_2, … 로 테이블을 분리하여 저장하는 것이다.

- 이 때 어떤 테이블에 저장될지를 hash function을 사용해서 결정한다.

- 가장 많이 사용될 패턴에 따라 partition key를 정하는 것이 중요하다.

- 데이터가 균등하게 분배될 수 있도록 hash function을 잘 정의하는 것도 중요하다.

- row 를 나누는 종류에는 여러가지 방법이 있을 수 있다.

- hash based

- range based

- 그 외…

Sharding (샤딩)

horizontal partitioning으로 나누어진 table들을 각각의 DB 서버에 저장하는 방식

- horizontal partitioning 처럼 동작함.

- 그러나, 각 partition이 독립된 DB 서버에 저장된다.

- 수평적 분할과 달리 다른 DB에 저장함으로서, 부하 분산을 시킬 수 있다.

- 부하 분산이 목적

- partiton key를 shard key라고 부름.

- 각 파티션(partition)을 shard라고 부름.

replication

DB를 복제해서 여러 대의 DB 서버에 저장하는 방식

- 기존 데이터베이스의 정보를 copy하여 다른 DB 서버에 저장하는 것

- 저장되는 서버를 (slave/secondary/replica) 라고 부름

- 고가용성을 위해 사용됨

- 기존 database가 장애가 생기면 빠르게 replica된 database를 사용할 수 있도록 하는 것이다.

- (fail over) 이중화 방식

- 고가용성 (High Availability - HA)

- 고가용성 뿐만 아니라, DB에 가중되는 부하를 분산시키는 목적으로도 사용된다.

- SELECT 와 같은 read only 쿼리는 replica DB에서 처리할 수 있지만,

- write 트래픽이 많은 경우 replica를 통한 부하 분산은 효과적이지 않다.

- 이 경우, multi-master, sharding 과 같은 방법을 사용할 수 있음.

- replication의 copy 방식에는 여러 방식이 존재한다.

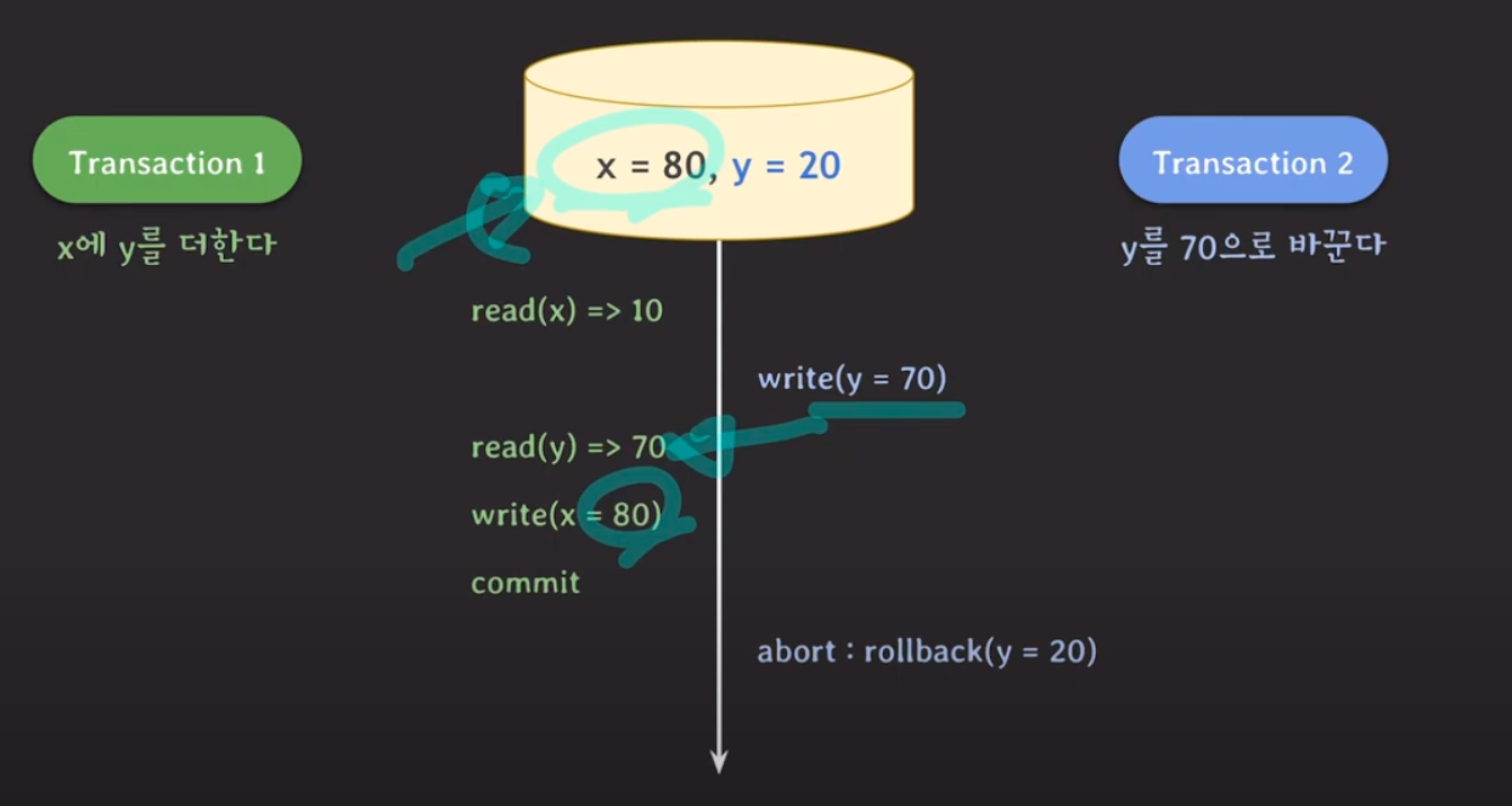

Database Transaction

Transaction

- 단일한 논리적인 작업 단위 (a single logical unit of work)

- 논리적인 이유로 여러 SQL 문들을 단일 작업으로 묶어서 나눠질 수 없게 만든 것이 transaction

- transaction의 SQL 문들 중에 일부만 성공해서 DB에 반영되는 일은 일어나면 안된다.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

CREATE TABLE account (

...,

balance INT,

check (balance >= 0)

);

START TRANSACTION;

UPDATE account SET balance = balance - 200000 WHERE id = 'J';

UPDATE account SET balance = balance + 200000 WHERE id = 'H';

COMMIT;

-- 지금까지 작업한 내용을 DB에 영구적으로 (permanently) 저장하라.

-- transaction을 종료한다.

START TRANSACTION;

UPDATE account SET balance = balance - 200000 WHERE id = 'J';

ROLLBACK;

-- 지금까지 작업들을 모두 취소하고 transaction 이전 상태로 되돌린다.

-- transaction을 종료한다.

-- 각각의 SQL문을 자동으로 transaction 처리해주는 개념

-- SQL문이 성공적으로 실행하면 자동으로 commit 된다.

-- 실행 중에 문제가 있었다면 알아서 rollback 된다.

-- MySQL에서는 default로 auto commit이 켜져있다.

-- 다른 DBMS에서도 대부분 같은 기능을 제공한다.

SELECT @@AUTOCOMMIT; -- 현재 auto commit 상태를 확인할 수 있다.

SET autocommit = 0; -- auto commit을 끈다.

DELETE FROM account WHERE balance <= 1000000;

ROLLBACK;

-- AUTO COMMIT이 비활성화 되었기 때문에 DELETE가 롤백된다.

-- 따라서 이 경우 COMMIT 명령어를 명시적으로 호출해야 한다.

- ACID

- Atomicity (원자성)

- 트랜잭션이 모두 완료되거나 완료되지 않아야 함.

- ALL or NOTHING

- transaction은 논리적으로 쪼개질 수 없는 작업 단위이기 때문에 내부의 SQL 문들이 모두 성공해야 한다.

- 중간에 SQL문이 실패하면, 지금까지의 작업을 모두 취소하여 아무 일도 없었던 것처럼 rollback 해야 한다.

- commit 실행 시, DB에 영구적으로 저장하는 것은 DBMS가 담당하는 부분이다.

- rollback 실행 시 이전 상태로 되돌리는 것도 DBMS가 담당하는 부분이다.

- 개발자는 언제 commit 하거나 rollback 할지를 결정해야 한다.

- Consistency (일관성)

- 데이터의 일관성을 보장

- transaction은 DB상태를 consist 상태에서 또 다른 consist 상태로 바꿔줘야 한다.

- constrains, trigger 등을 통해 정의된 rule을 transaction이 위반했다면 rollback 해야 한다.

- transaction이 DB에 정의된 rule을 위반했는지는 DBMS가 commit 하기 전에 확인하고 알려준다.

- 그 외에 application 관점에서 transaction이 consistent 하게 동작하는지는 개발자가 챙겨야 한다.

- Isolation (독립성)

- 여러 트랜잭션이 동시에 처리될 때에도 독립성을 보장

- 여러 transaction들이 동시에 실행될 때에도 혼자 실행되는 것처럼 동작하게 만든다.

- DBMS는 여러 종류의 isolation level을 제공한다.

- 개발자는 isolation level 중에 어떤 level로 transaction을 동작시킬지 설정할 수 있다.

- isolation level이 낮을 경우 동시에 여러 transaction이 실행될 수 있지만, 동시성 문제가 발생할 가능성이 높아짐.

- 개발자는 isolation level 중에 어떤 level로 transaction을 동작시킬 지 설정할 수 있다.

- concurrency control의 주된 목표가 isolation이다.

- Durability (지속성, 영존성)

- DB 서버에 문제가 발생했을 때에도 commit 된 데이터는 손실되지 않는 지속성

- commit된 transaction은 DB에 영구적으로 저장되어야 한다.

- 즉, DB system에 문제 (power fail, DB crash 등)가 생겨도 commit된 transaction은 DB에 남아 있어야 한다.

- 영구적으로 저장한다 라고 할 때에는 일반적으로 ‘비휘발성 메모리(HDD, SSD…)에 저장함’을 의미한다.

- 기본적으로 transaction의 durability는 DBMS가 보장한다.

- Atomicity (원자성)

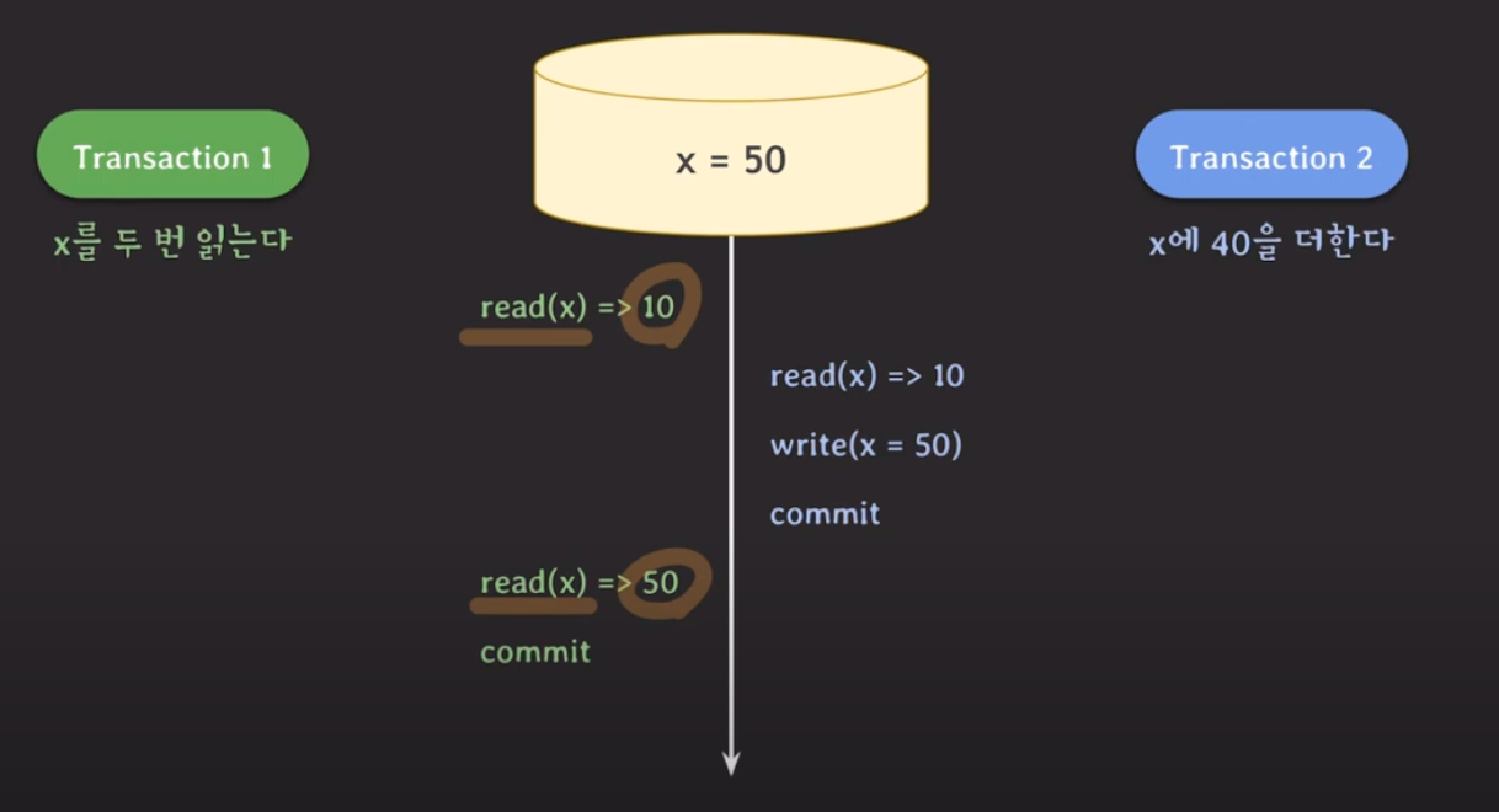

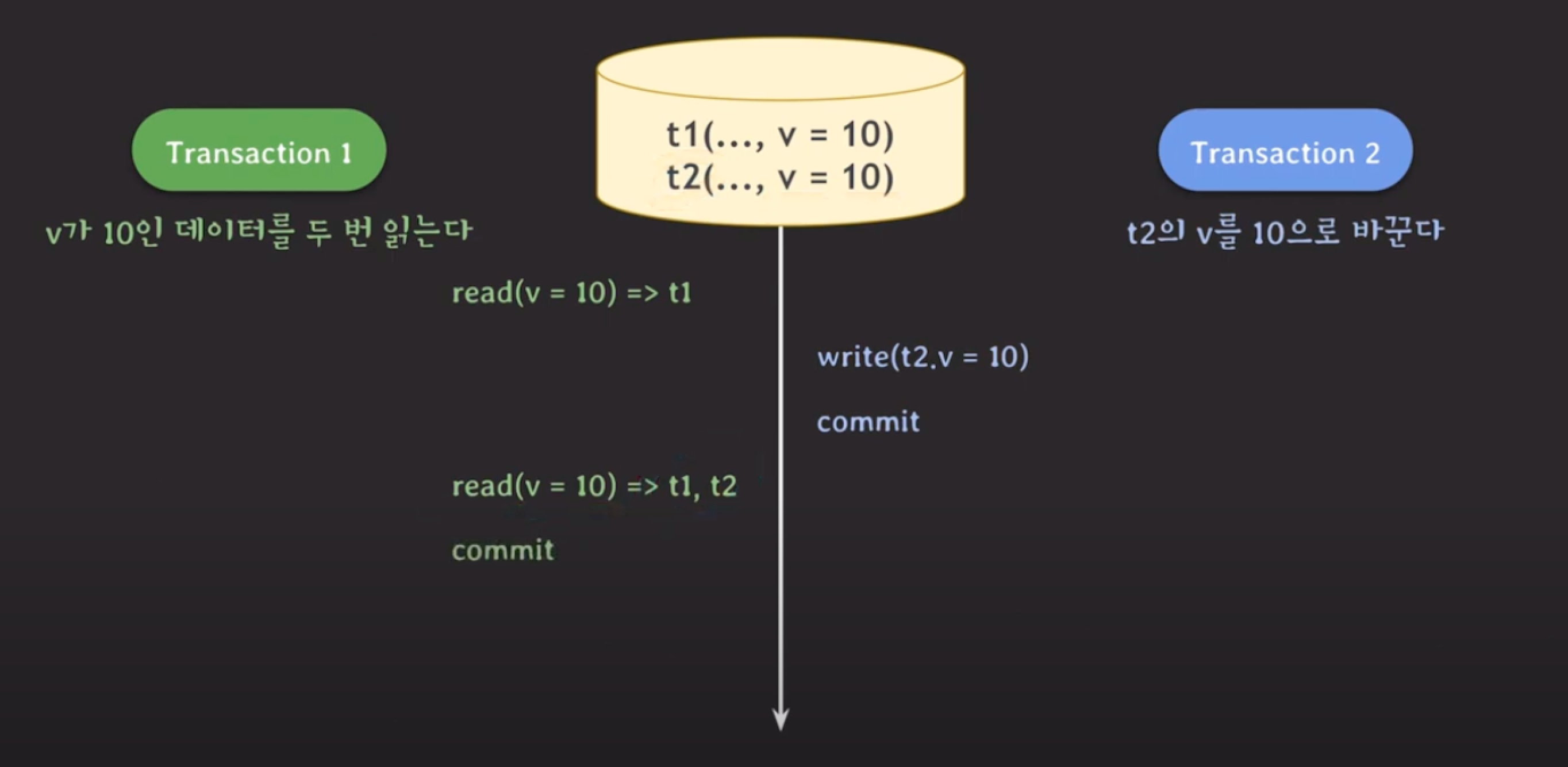

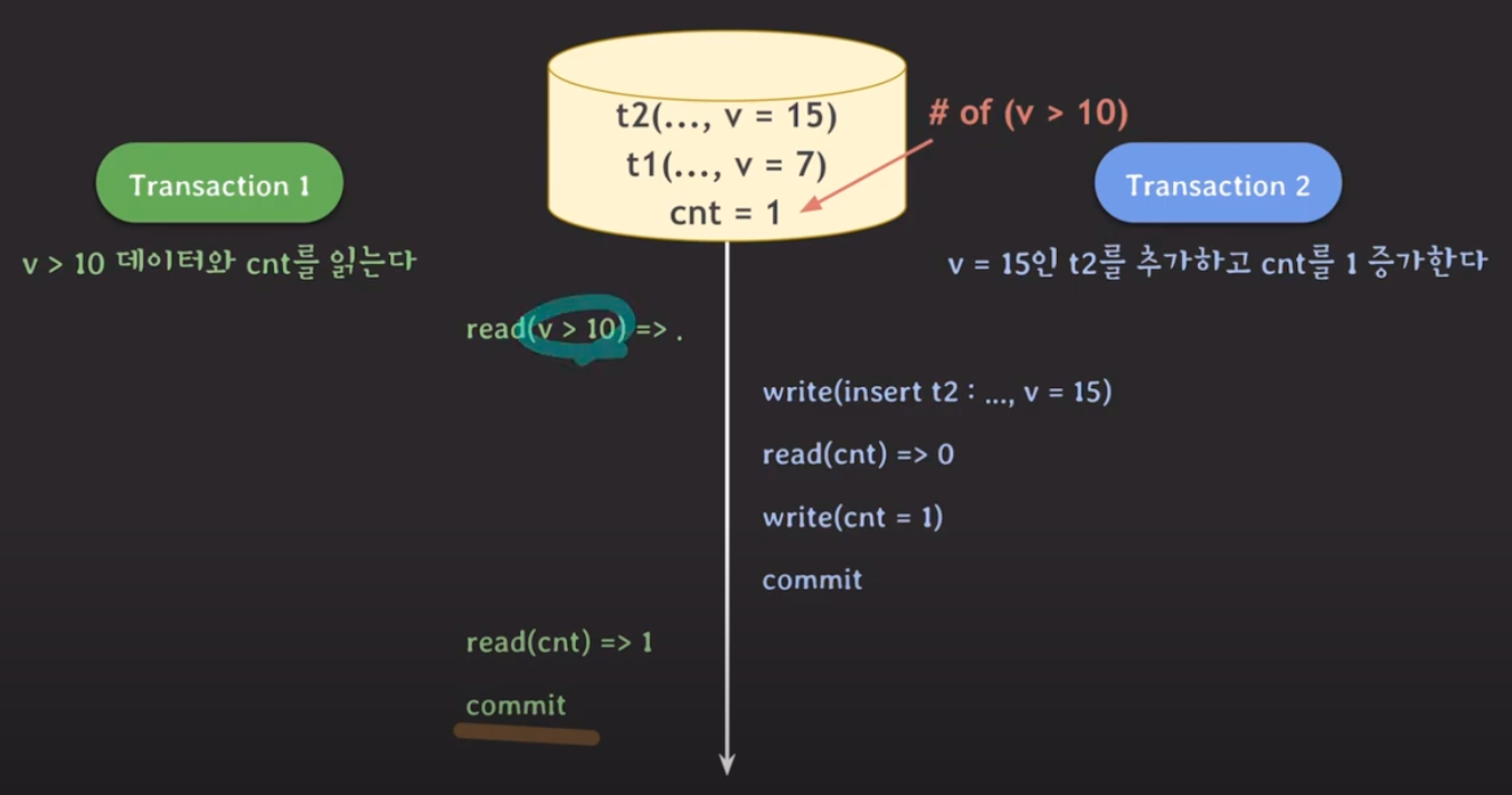

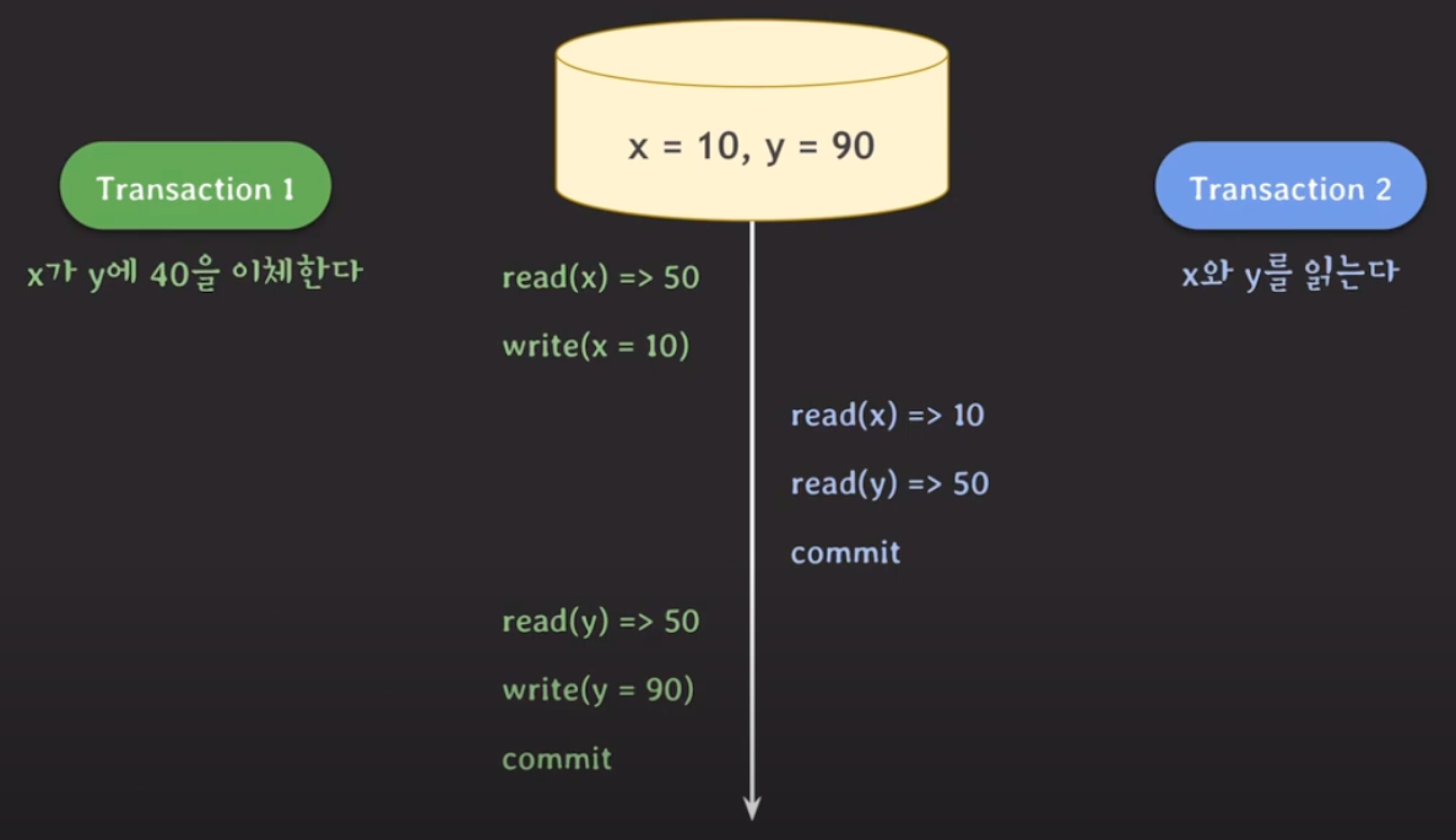

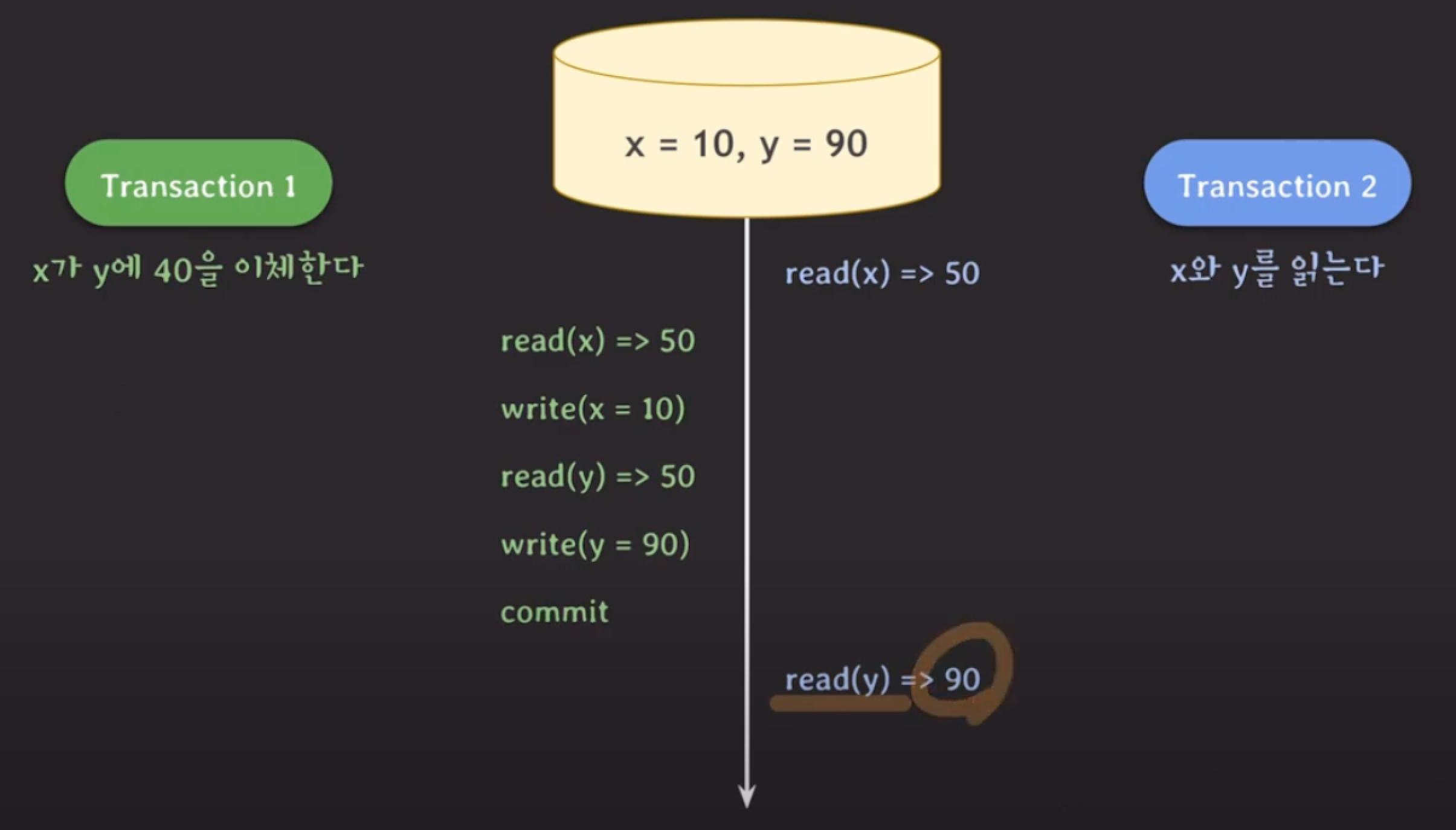

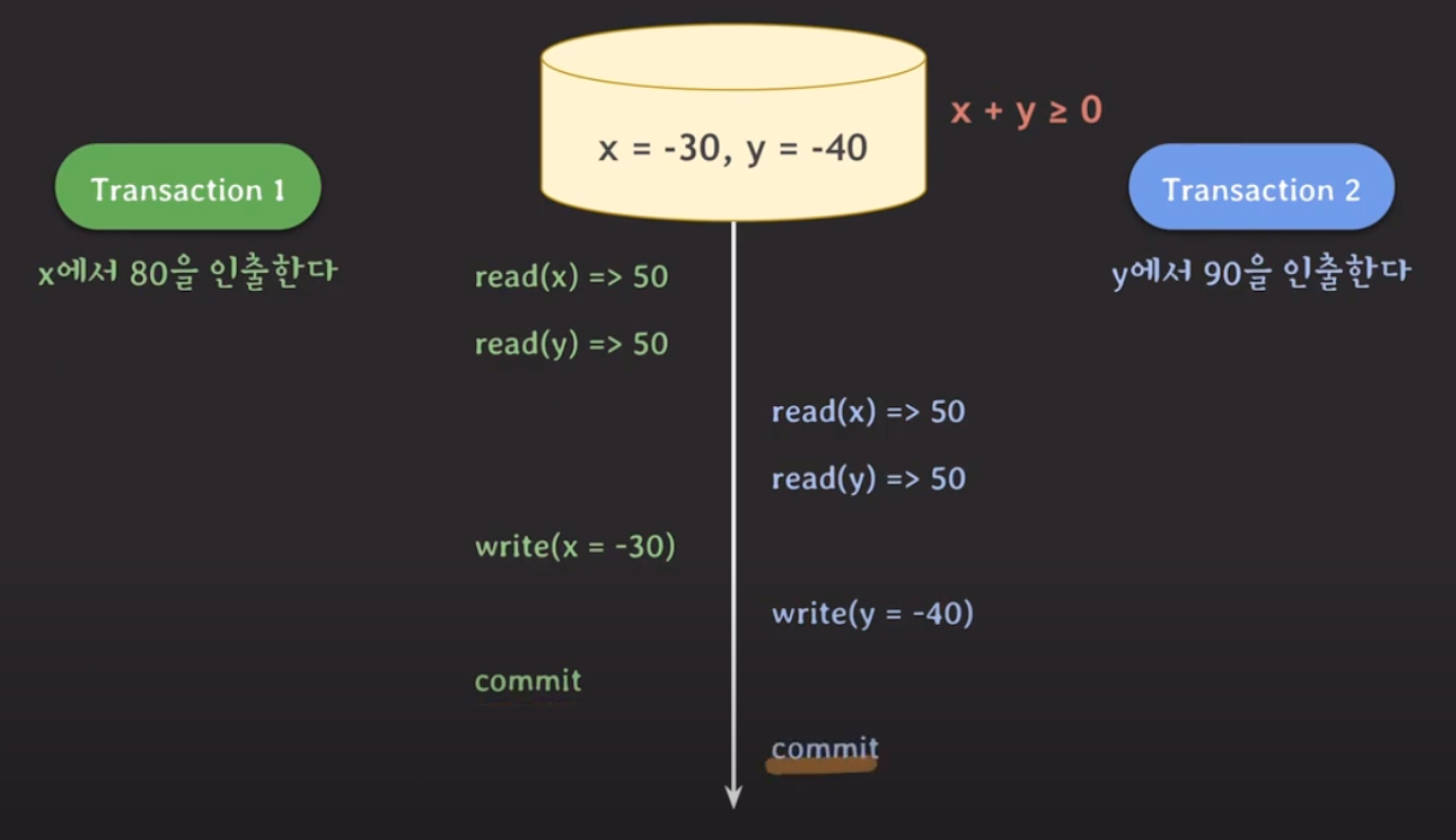

Isolation이 되지 않을 때 발생할 수 있는 문제

- dirty read

- non-repeatable read (Fuzzy Read)

- phantom read

이런 이상한 현상들이 모두 발생하지 않게 만들 수 있지만, 그러면 제약 사항이 많아져서 동시 처리 가능한 트랜잭션의 수가 줄어들어 결국 DB의 전체 처리량(throughput)이 떨어진다.

- 일부 이상한 현상은 허용하는 몇 가지 level을 만들어서 사용자가 필요에 따라서 적절하게 선택할 수 있도록 하자.

Isolation Level

애플리케이션 설계자는 isolation level을 통해 전체 처리량 (throughput)과 데이터 일관성 사이의 어느정도 거래(trade)를 할 수 있다.

- Read Uncommitted (커밋되지 않은 데이터도 읽음)

- Dirty Read (O)

- Non-Repeatable Read (O)

- Phantom Read (O)

- Read Committed (커밋된 데이터만 읽음)

- Dirty Read (X)

- Non-Repeatable Read (O)

- Phantom Read (O)

- Repeatable Read (반복 읽기)

- Dirty Read (X)

- Non-Repeatable Read (X)

- Phantom Read (O)

- Serializable (직렬화)

- 아예 이상한 현상 자체가 발생하지 않는 level을 의미함!

- Dirty Read (X)

- Non-Repeatable Read (X)

- Phantom Read (X)

그 외에도 여러 이상한 현상들이 있음.

- dirty write

- commit이 되지 않은 데이터를 write할 때 발생할 수 있음.

- Rollback 할 때 문제 발생

- Rollback 시 정상적인 recovery는 매우 중요하기 때문에, 모든 isolation level에서 dirty write를 허용하면 안 된다.

- commit이 되지 않은 데이터를 write할 때 발생할 수 있음.

- lost update

- 업데이트를 덮어 쓸 때 발생할 수 있음.

- 두 개의 transaction이 같은 데이터를 동시에 수정하는 경우, 한 개의 transaction 변화가 소실되는 경우

- dirty read 확장판

- read skew

- write skew

SNAPSHOT ISOLATION

- concurrency control 을 어떻게 진행할 것인지에 따라 레벨을 결정함.

write lock (exclusive lock)

- read / write (insert, modify, delete) 할 때 사용한다.

- 다른 tx가 같은 데이터를 read / write 하는 것을 허용하지 않는다.

read lock (shared lock)

- read 할 때 사용한다.

- 다른 tx가 같은 데이터를 read 하는 것을 허용한다.

2PL (Two-Phase Locking)

- tx에서 모든 locking operation이 최초의 unlock operation 보다 먼저 수행되도록 하는 것

RDBMS(Relation DataBase Management System) vs NoSQL (mongodb, redis)

- RDBMS의 단점

- 데이터 타입 변경에 따른 칼럼 추가/삭제 등 빠른 대응이 어렵다.

- 이미 데이터가 많이 있는 상황에서 스키마 변경 또는 칼럼을 추가/삭제는 부담이 된다.

- 유연한 확장성 부족

- 중복 제거를 위해 정규화를 진행하면, JOIN 쿼리가 많이 발생할 수 있다.

- 복잡한 JOIN 쿼리는 성능 저하를 일으킬 수 있다.

- RDBMS는 일반적으로 scale-out에 유연한 DB는 아니다.

- ACID를 보장하려다보니 DB 서버의 performance에 어느 정도 영향을 미침

- 데이터 타입 변경에 따른 칼럼 추가/삭제 등 빠른 대응이 어렵다.

- high throughput과 low-latency를 요구함.

- 비정형 데이터의 증가

Not Only Structured Query Language (NoSQL)

특징

- Flexible schema (유연한 스키마)

- MongoDB는 json 형태로 정보를 넣어준다.

- 스키마를 사전에 정의하지 않아도 된다.

- MongoDB는 row, tuple이 아닌, document 라고 부른다.

- MongoDB는 각 document에 대한 _id 를 자동으로 생성해준다.

- 중복을 허용한다. (join 회피)

- application 레벨에서 중복된 데이터들이 모두 최신 데이터를 유지할 수 있도록 관리해야 한다.

- scale-out에 최적화되어 있다.

- 서버 여러 대로 하나의 클러스터를 구성하여 사용함.

- 각각의 서버가 데이터를 나누어서 저장함.

- ACID이 일부를 포기하고 high throughput과 low-latency를 추구

- 금융 시스템처럼 consistency가 중요한 환경에서는 사용하기가 조심스러움.

- REDIS

- in-memory key-value database, cache or …

- data type: string, lists, sets, hashes, sorted sets, …

- hash-based sharded cluster

- High Availability (replication, automatic failover)

데이터 백업

jpa n + 1 문제

jpa n + 1 문제 n+1 관계 설정 및 관계가 설정된 데이터를 조회하려 할 때, 조회 쿼리가 n번 발생하는 문제이다.

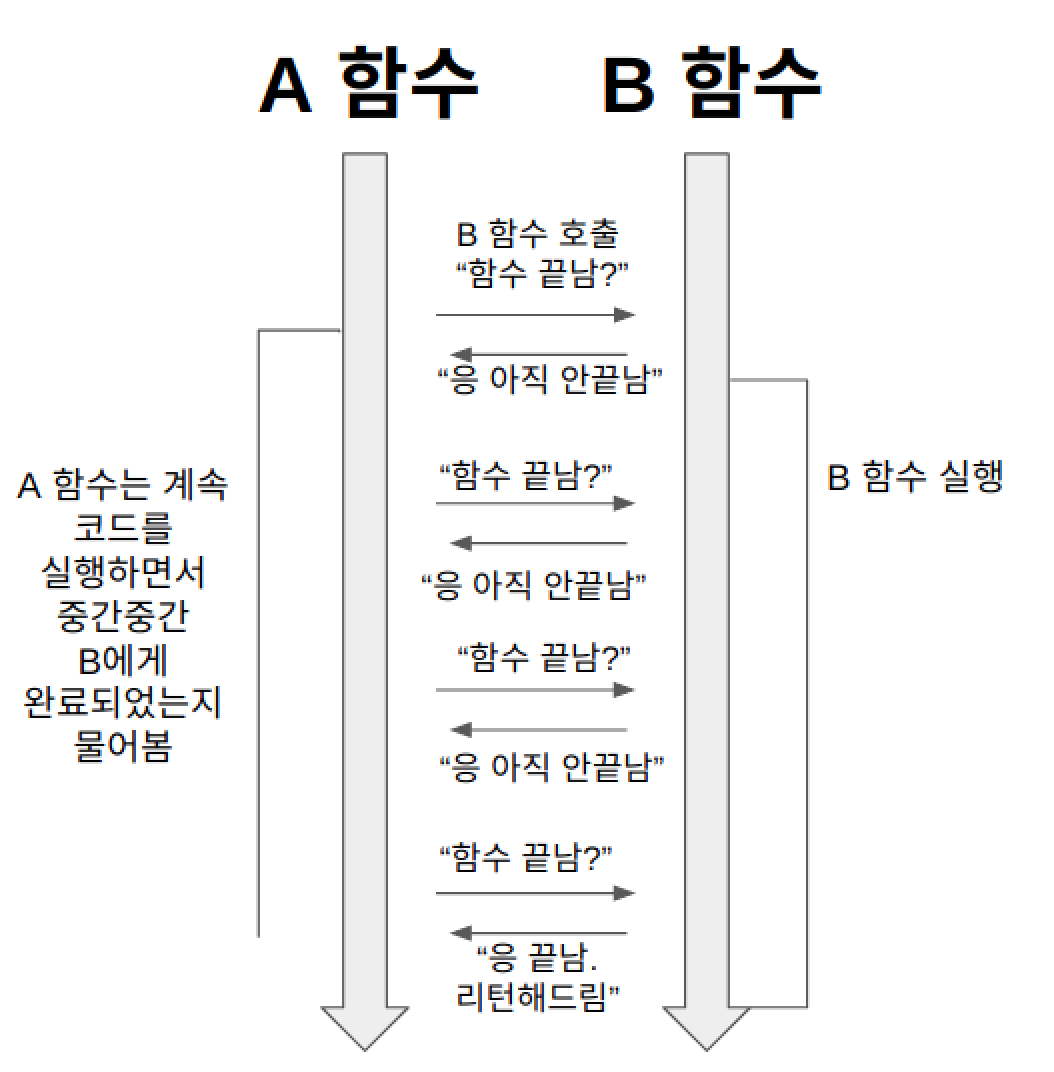

동기와 비동기, Blocking과 Non-Blocking 의 차이점

Blocking은 함수의 제어권을 담당하는 여부

- Blocking IO

- 제어권은 호출한 함수에 넘겨줌

- Non-Blocking IO

- 제어권은 호출한 함수에 넘겨주지 않음

sync는 호출되는 함수의 작업 완료를 기다리는 여부

- sync

- 호출되는 함수의 리턴값을 확인(기다림)

- async

- 호출되는 함수의 리턴값을 기다리지 않음. (대신 콜백 함수를 함께 전달해 함수 B의 작업이 끝나면 콜백 함수를 실행함)

- Blocking / Synchronous

- 일반적인 함수의 동작 과정

-

- A 함수는 B 함수를 호출한다. 이 때 A 함수는 B 함수에게 제어권을 주지 않고, 자신의 코드를 계속 실행한다(논블로킹).

- 그런데 A 함수는 B 함수의 리턴값이 필요하기 때문에, 중간중간 B 함수에게 함수 실행을 완료했는지 물어본다(동기).

- B 함수는 자신의 작업이 끝나면 A 함수가 준 콜백 함수를 실행한다(비동기).

- Asynchronous / Non-Blocking 비동기 논블로킹은 이해하기 쉽다. 자바 스크립트의 비동기 함수 동작 방식 A 함수는 B 함수를 호출한다. 이 때 제어권을 B 함수에 주지 않고, 자신이 계속 가지고 있는다(논블로킹). 따라서 B 함수를 호출한 이후에도 멈추지 않고 자신의 코드를 계속 실행한다. 그리고 B 함수를 호출할 때 콜백함수를 함께 준다. B 함수는 자신의 작업이 끝나면 A 함수가 준 콜백 함수를 실행한다(비동기).

Async-blocking의 경우 sync-blocking과 성능의 차이가 또이또이하기 때문에 사용하는 경우는 거의 없다.

- Blocking / NonBlocking - 제어권 : socket통신으로 설명

- Synchronous / Asynchronous : 리턴값에 대한 차이 (js의 콜백함수 등, 함수의 리턴값을 기다리지 않음)

- JS는 single-thread + non-blocking + async 방식

- Blocking Socket

-

accept,read에서 멈춤1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26

#include <sys/socket.h> #include <netinet/in.h> #include <unistd.h> #include <string.h> int main() { int server_fd = socket(AF_INET, SOCK_STREAM, 0); struct sockaddr_in address; address.sin_family = AF_INET; address.sin_addr.s_addr = INADDR_ANY; address.sin_port = htons(8080); bind(server_fd, (struct sockaddr*)&address, sizeof(address)); listen(server_fd, 3); while(1) { int client_fd = accept(server_fd, NULL, NULL); // ←← 블로킹! char buffer[1024]; read(client_fd, buffer, 1024); // ←← 블로킹! write(client_fd, "HTTP/1.1 200 OK\r\n\r\nHello", 26); close(client_fd); } return 0; }

-

- NonBlocking Socket

-

fcntl(fd, F_SETFL, O_NONBLOCK)설정 후 즉시 리턴 -

select여러 소켓을 동시에 모니터링 가능 ```c // 이외에도 select, epoll 등을 호출해 사용할 수 있다. #include <sys/socket.h> #include <netinet/in.h> #include#include #include int main() { int server_fd = socket(AF_INET, SOCK_STREAM, 0); fcntl(server_fd, F_SETFL, O_NONBLOCK); // ←← 논블로킹 설정!

struct sockaddr_in address; address.sin_family = AF_INET; address.sin_addr.s_addr = INADDR_ANY; address.sin_port = htons(8080);

bind(server_fd, (struct sockaddr*)&address, sizeof(address)); listen(server_fd, 3);

while(1) { int client_fd = accept(server_fd, NULL, NULL); // 즉시 리턴

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15

if(client_fd < 0) { if(errno == EAGAIN || errno == EWOULDBLOCK) { // 연결 없음, 다른 작업 가능 printf("다른 작업 중...\n"); usleep(100000); // 0.1초 대기 continue; } } else { char buffer[1024]; fcntl(client_fd, F_SETFL, O_NONBLOCK); if(read(client_fd, buffer, 1024) > 0) { write(client_fd, "HTTP/1.1 200 OK\r\n\r\nHello", 26); } close(client_fd); } } return 0; } ``` -

운영체제의 paging 과 page fault

페이징은 프로세스가 차지하는 물리적 메모리 공간이 비연속적이 되도록 허용하는 메모리 관리 기법을 말한다. 페이징은 외부 단편화가 발생하지 않으며, 따라서 별도의 Compaction 과정이 필요하지 않다.

- 다양한 크기의 메모리 덩어리(Chunk)들을 Backing store에 맞춰야 하는 문제를 해결해줌.

- 이 문제는 메인 메모리를 차지한 코드나 데이터가 swap out될 때, 그만한 공간을 Backing store에서 찾아야 하기 때문에 발생.

- Backing store에서도 동일하게 단편화 문제가 발생하지만, 메인 메모리에서보다 접근 속도가 훨씬 느리기 때문에 Compaction을 적용할 수 없다.

이러한 장점들 때문에 현재 대부분의 운영체제에서 다양한 형태로 사용되는 방법이다.

페이징을 구현하는 기본적인 방법은 물리적 메모리를 고정된 크기의 프레임(Frame)으로 나누고, 논리적 메모리를 동일한 크기의 페이지(Page)로 나누는 것 프로세스가 실행되면 프로세스의 페이지들은 메모리의 사용가능한 프레임으로 적재된다. Backing store 역시 고정된 크기의 block들로 나누어진다. CPU에 의해 생성된 모든 주소들은 페이지 번호(Page Number, p)와 페이지 간격(Page Offset, d)로 나뉜다. 페이지 번호는 페이지 테이블의 인덱스로써 사용된다.

페이징 기법을 사용할 때, 외부 단편화는 발생하지 않는다. 모든 사용 가능한 프레임은 그것을 필요로 하는 프로세스에게 할당될 수 있기 때문이다. 하지만 내부 단편화는 발생할 수 있다. 프레임은 일정한 크기로 할당되기 때문이다.

- 페이지의 크기는 왜 4KB인가?

- 내부 단편화와 외부 단편화의 균형

- 페이지가 너무 크면: 내부 단편화 증가 (메모리 낭비)

- 페이지가 너무 작으면: 페이지 테이블이 커져서 오버헤드 증가

- 4KB는 이 둘 사이의 적절한 균형

- TLB (Translation Lookaside Buffer) 효율성

- TLB는 가상-물리 주소 변환 정보를 캐시하는 하드웨어

- TLB 엔트리 개수가 제한적이라 페이지가 너무 작으면 TLB 미스가 자주 발생

- 4KB면 적당한 TLB 효율성 확보

- 역사적 배경

- 1980년대 ~ 1990년대 하드웨어 환경에서 최적화된 크기

- 당시 메모리 크기 (MB 단위)와 프로그램 크기를 고려한 설계

- x86 아키텍쳐에서 표준으로 채택되면서 널리 퍼짐

- 페이지 테이블 관리 오버헤드

- 32비트 시스템에서 4GB 주소 공간을 4KB로 나누면 1M개 페이지

- 페이지 엔트리당 4바이트면 페이지 테이블이 4MB (관리 가능한 크기)

- 더 작은 페이지면 테이블이 너무 커짐

- 디스크 I/O 효율성

- 대부분의 파일 시스템 블록 크기가 4KB 근처

- 페이지와 블록 크기가 비슷하면 스왑 효율성 증대

- 캐시 라인과의 호환성

- CPU 캐시 라인 크기와 어느 정도 맞아떨어짐

- 메모리 접근 패턴 최적화에 유리

- 현재는?

- 메모리가 많아지면서 큰 페이지(2MB, 1GB)도 지원

- Huge Pages, Large Pages 등으로 불림

- 데이터베이스나 대용량 애플리케이션에서 성능 향상 목적으로 사용

- 결국 4KB는 과거 하드웨어 환경에서 여러 요소들을 종합적으로 고려해서 나온 “최적해”였는데, 지금도 대부분의 일반적인 용도에서는 여전히 적절한 크기라고 볼 수 있음.

- 내부 단편화와 외부 단편화의 균형

- 스왑 (Swap)

- 메모리가 부족할 때 사용하는 “가상 메모리 확장” 기법

- 물리 메모리(RAM)이 가득 찰 때, 당장 안 쓰는 데이터를 디스크에 임시 저장

- 나중에 그 데이터가 필요하면 다시 메모리로 불러옴 (메모리 창고 같은 역할)

Internal Fragmentation(내부 단편화)

- Partitioning 상황에서 발생한다.

- Partition의 크기가 프로세스의 크기보다 커서 메모리가 남지만, 다른 프로세스가 사용할 수 없는 상태를 말한다.

100MB의 공간(Partition)에 Process C를 할당했다. 20MB의 여유 메모리가 존재하지만 Process C 에게 할당되어 사용할 수 없다. 이를 내부단편화라고 한다.

External Fragmentation(외부 단편화)

50MB의 두 여유 메모리가 존재하고 총 100MB의 여유 메모리가 존재한다. 그러나, 연속적이지 않은 공간에 존재하여 80MB인 Process C를 실행할 수 없다. 이를 외부단편화라고 한다. Compaction을 사용하여 외부단편화를 줄일 수 있다. Compaction : 흩어져 있던 공간을 하나의 연속적인 공간으로합치는 기법 구현이 복잡하다.

정수와 실수의 표현 방식

- 정수 자료형은 어떻게 표현하는가?

- 부호비트와 크기비트를 사용해 표현한다.

- 부호비트: 0은 양수, 1은 음수

- 크기비트: 비트의 크기

- 음수 표현 시 2의 보수를 사용함

-

-1표현- 1의 이진수 표현

- 1 =

00000001

- 1 =

- 1의 보수 표현 (모든 비트 뒤집기)

-

00000001->11111110

-

- 1을 더하기

-

11111110+00000001=11111111

-

- 1의 이진수 표현

-

-2표현- 2의 이진수 표현

- 2 =

00000010

- 2 =

- 2의 보수 표현 (모든 비트 뒤집기)

-

00000010->11111101

-

- 1을 더하기

-

11111101+00000001=11111110

-

- 2의 이진수 표현

-

- 2의 보수를 사용하기 때문에 맨 앞자리를 보면 바로 양수/음수 구분이 가능하다.

- 이렇게 부호 비트를 활용할 수 있는 것.

- 부호 비트를 사용하지 않을 경우

unsigned타입을 사용하면 된다.-

signed int: -2147483648 (2^31) ~ 2147483647 (2^31 - 1) -

unsigned int: 0 ~ 4294967295 (2^32 - 1)

-

- 예시

- 8비트 정수 표현

- 00000000: 0

- 00000001: 1

- 00000010: 2

- 00000011: 3

- 00000100: 4

- 00000101: 5

- 00000110: 6

- 00000111: 7

- 11111111: -1

- 11111110: -2

- 11111101: -3

- 11111100: -4

- 11111011: -5

- 11111010: -6

- 11111001: -7

- 8비트 정수 표현

- 부호비트와 크기비트를 사용해 표현한다.

- 실수자료형은 어떻게 표현하는가?

- 고정 소수점 방식과 부동 소수점 방식이 존재한다.

- 고정 소수점 방식은 소수점의 위치를 고정시키는 방식이다.

- 일상적으로 쓰는, 0 뒤에 소수점을 붙이는 방식을 기반으로 한다. 이를테면 8비트로 실수를 표현할 때 보통 ‘8비트의 앞 4비트는 정수부를, 뒤 4비트는 소수부를 나타낸다’라고 정해 놓는다. 그러면 1010.0111(2)을 ‘1010 0111’로, 11.011(2)은 ‘0011 0110’으로 나타낼 수 있다.

- 고정 소수점 방식은 빠르지만, 표현할 수 있는 수의 범위가 제한적이다.

- 그러나 데이터 특성이나 알고리즘에 따라 고정소수점 방식이 정확도도 좋고 빠른 경우가 존재할 수 있다.

- 소수부를 이진수로 표현하기 때문에 (표현하지 못하는 수도 있지만, 표현하는 수가 제한적이거나 하는 등)

- 고정 소수점 방식은 소수점의 위치를 고정시키는 방식이다.

- 부동소수점

- 일반적으로 범용적인 상황에서 대체로 고정 소수점 방식보다 더 높은 정확성을 보장한다.

- 그러나 고정 소수점 방식에 비해 실수 저장에 더 많은 연산이 필요하다는 단점이 존재한다. (지수부 계산 등)

- 이진수의 지수 표기법을 사용해 부동소수점을 표기한다.

- (+-)

x+y^n- (+-) : 부호

-

x: 가수 -

y: 기수 -

n: 지수

- 십진수 지수(exponent) 표기법

- 123.456 -> 123456e-3

- 123e2 -> 12300

- 123e-2 -> 1.23

- Float

- 32bit: 1bit(부호) + 8bit(지수) + 23bit(가수)

- Double

- 64bit: 1bit(부호) + 11bit(지수) + 52bit(가수)

- 118.625 를 float type (부동소수점) 방식으로 표현

- 118.625 = 1110110.101

- 정수 118 = 1110110

- 소수 0.625 = 101 = 0.625 * 2 = 1.250 = 0.250 * 2 = 0.500 = 0.500 * 2 = 1.000 -> 101

- 번외 ```

- 소수 표기법

- 0.1(2) - 0.5(10)

- 0.01(2) - 0.25(10)

- 0.001(2) - 0.125(10)

- 0.0001(2) - 0.0625(10) ```

- 소수점을 왼쪽으로 이동시켜 정수부가 한 자리가 되도록 한다.

- 1110110.101 -> 1.110110101 (6자리 이동)

- 이동시킨 자릿수(6) 만큼을 2의 지수를 사용해 곱해주고 , 이 수를 정규화된 부동 소수점이라고 함.

- 1.110110101 * 2^6

- 소수점 아래 부분 (110110101) 이 가수부(23bit)가 되도록 나머지 비트를 채움.

- 11011010100000000000000 * 2^6

- 부호 비트와 가수부를 설정함. (음수라서 부호 비트 1 설정, 8비트 (지수부) 띄우고 가수부(23bit) 설정)

1xxxxxxxx11011010100000000000000

- 지수부를 설정함.

- 32bit IEEE 754 형식에는 “Bias” 라는 고정된 값이 있음. 이는 127이며, bias를 2의 지수인 6에 더하고 2진수로 변환한다.

- 127 + 6 = 133

- 133(10) -> 10000101(2)

- Bias 값을더해주는 이유

- 음수 지수 표현의 단순화

- 음수 지수를 양수로 변환해 저장할 수 있음.

- 비교 연산의 효율성

- 숫자를 정규화시켜 수들의 비교가 더 쉬워짐.

- -2, -3을 Bias를 사용해 (125, 130) 으로 표현할 수 있음.

- 따라서 부호 있는 비교가 필요없기 때문에 비교 연산이 더 빠름.

- 숫자를 정규화시켜 수들의 비교가 더 쉬워짐.

- 특수값 처리의 용이성

- 지수부가 모두 0(언더플로우) 이나 1(오버플로우/무한대) 인 경우 쉽게 감지할 수 있음.

- 음수 지수 표현의 단순화

- 32bit IEEE 754 형식에는 “Bias” 라는 고정된 값이 있음. 이는 127이며, bias를 2의 지수인 6에 더하고 2진수로 변환한다.

- 최종 표현

11000010111011010100000000000000

- 고정 소수점 방식과 부동 소수점 방식이 존재한다.

BigO

- BigO 표기법의 O는 무엇이지? (Ordnung 오르드눙 notation)

- 그 외에 사용하고 있는 시간복잡도 표기법이 있는가?

- 특정한 자료구조를 Big O 표기법에 의해 설명해봐라.

- 리스트 설명함

- 오르드눙 (Ordnung)는 질서 , 규율, 규칙, 배열, 조직 또는 시스템을 의미하는 독일어

- 배열과 리스트의 차이점을 CS를 모르는 일반인 고등학생 정도의 사람들에게 설명한다고 가정하고 말해봐라.

- 트리를 컴퓨터 전공자에게 설명한다고 가정하고 말해봐라.

Thread (멀티 스레드 vs 멀티 프로세스)

- 스레드는 무엇이고 서로 다른 스택을 가지는가? / 만약 그렇다면, 왜 각각의 스택을 가지는가?

내가 멀티프로세스 환경에서 주로 개발함으로 인해 멀티스레드 기반 기술 스택을 가진 회사에서 이러한 스레드 관련 CS를 집중적으로 물어봄. 따라서 이는 무조건 공부해가야 한다.

- 스레드가 공유하는것들

- 코드 영역 (프로그램 코드)

- 데이터 영역 (전역 변수)

- 힙 영역 (동적 할당 메모리)

- 파일 디스크립터 (열린 파일들)

- 프로세스 ID (PID)

- 메모리 매핑 테이블

- 스레드가 가지는 것들 (독립적)

- CPU 레지스터들 (PC, SP, 범용레지스터)

- 스택 영역 (지역 변수, 함수 호출 정보)

- 스레드 ID

- 실행 상태 (Ready, Running, Blocked 등)

- 코드영역 (프로그램 코드), 데이터 영역 (전역 변수), 힙 영역 (동적 할당 메모리) 는 서로 공유한다.

- 하지만 스레드의 스택은 각 스레드마다 독립적으로 존재한다. 아래와 같은 이유로 독립적인 스택을 가짐.

- 독립적인 함수 호출 관리

- 지역변수의 독립성

- 재귀함수의 안전성

- 컨텍스트 스위칭

- 또한 스레드는 자신만의 레지스터 컨텍스트를 가진다.

- 스레드 컨텍스트 스위칭 (가벼움)

- 현재 스레드의 레지스터 저장

- 새 스레드의 레지스터 복원

- 스택 포인터만 변경

- 프로세스 컨텍스트 스위칭 (무거움) 1. 현재 프로세스의 모든 상태 저장 2. 메모리 매핑 테이블 전환 (MMU 설정 변경) 3. 캐시 무효화 4. 새 프로세스의 메모리 공간으로 전환 5. 새 프로세스의 상태 복원

- 레지스터: CPU의 물리적 저장 공간 (하드웨어)

레지스터 컨텍스트: 특정 순간의 모든 레지스터 값들 (소프트웨어적 개념)

- 뮤텍스 (Mutex) 와 세마포어 (Semaphore) 의 차이점에 대해 설명해라.

- 뮤텍스 Mutex = 락 Lock

- 공유 데이터를 보호할 때 (전역 변수, 파일 쓰기 등) (공유 자원에 대한 상호 배제)

- 소유권: O

- 용도: 상호 배제

- 동시 접근: 1개의 스레드만

- 값 범위: 0 또는 1

- 세마포어 Semaphore

- 리소스 풀 관리 (DB 커넥션 풀, 스레드 풀 등), Producer-Consumer 패턴, 스레드 간 신호 전달 목적

- 동기화 및 순서 제어

- 리소스 카운팅 (DB 커넥션이 5개 있고, 커넥션 하나 가져갔다가(sem_wait), 반납(sem_post))

- 제한된 동시 접근 허용 (프린터가 3대가 있어서 동시에 3명까지 사용 가능하지만, 스레드는 10개가 존재하여 제한된 동시 접근을 체크해야 할 때)

- 소유권: 없음 (아무나 signal 가능)

- 용도: 리소스 카운팅 + 신호 전달

- 동시 접근: n개의 스레드 (카운터 값)

- 값 범위: 0 이상의 정수

- 리소스 풀 관리 (DB 커넥션 풀, 스레드 풀 등), Producer-Consumer 패턴, 스레드 간 신호 전달 목적

- 뮤텍스 Mutex = 락 Lock

- 낙관적 락 / 비관적 락

- 낙관적 락

- 충돌이 거의 발생하지 않을 것이라고 가정하고 충돌이 발생한 경우 조치를 취하는 방식이다.

- 일반적으로 version의 상태를 보고 충돌을 확인하며, 충돌이 확인된 경우 롤백을 진행한다. (hashcode, timestamp를 이용하여 충돌을 확인하는 경우도 존재.)

1 2 3 4 5 6 7

version = 1, id = 1, name = "hwang", nick = "qwer" 1 req : id 1 의 name을 "lee"로 바꿔. (version = 1) 2 req : id 1 의 nick을 "asdf" 로 바꿔. (version = 1) 동시성 문제 발생 (1 req와 2 req 가 동시에 발생) 1 req -> version = 2, id = 1, name = "lee", nick = "qwer" 2 req -> 이미 버전이 2로 바뀌어 처리 불가

- 충돌이 발생할 경우에 대한 책임을 Application 단에서 짐, 따라서 충돌 발생 시 Application 에서 수동 Rollback 해줘야 함.

- 장점

- 리소스 발생 적음

- 락으로 인한 성능저하가 적음.

- 단점

- 충돌 발생 시 처리해야 할 외부 요인 존재

- 비관적 락

- 충돌이 발생할 확률이 높다고 가정하여, 데이터 엑세스 전 락을 걸어 충돌을 예방하는 방식이다.

- 공유 락(shared lock) 과 배타락(exclusive lock)이 존재.

- 공유락 : 다른 트랜잭션에서 읽기만 가능, 배타락 적용 불가

- 배타락 : 다른 트랜잭션에서 읽기, 쓰기 모두 불가, 공유락, 배타락 모두 적용 불가

- 장점

- 충돌 발생을 미연에 방지

- 데이터의 일관성 유지

- 단점

- 과도한 리소스 비용 발생

- 비관적 락이 잘못 걸리거나 서로 자원이 필요한 경우 교착상태의 발생 가능성 존재

- 낙관적 락

- Producer-Consumer 패턴 (이거 ipc_agent잖아…)

- Producer(생산자)-Consumer(소비자) 패턴

- 기본 개념

- Producer (생산자): 데이터를 만들어서 버퍼에 넣는 놈

- Consumer (소비자): 버퍼에서 데이터를 가져와 처리하는 놈

- Buffer (버퍼): 둘 사이의 임시 저장소 (보통 큐 형태)

- 비유

- Producer: 제품을 만들어서 벨트에 올리는 작업자

- Consumer: 벨트에서 제품을 가져와 포장하는 작업자

- Buffer: 컨베이어 벨트(제한된 공간)

- 문제점

- 버퍼가 가득 찰 때: 생산자가 기다려야 함

- 버퍼가 비었을 때: 소비자가 기다려야 함

- 동시 접근: 둘이 동시에 버퍼를 건드리면 깨짐

- 사용 예시

- 메시지 큐(Kafka, RabbitMQ), 스트리밍, 로그 시스템, 웹서버 등

- 동기화 방법들

- 세마포어: 버퍼 공간 관리

- 뮤텍스: 동시 접근 방지

- 조건 변수: 대기/알림 매커니즘

- 이 패턴의 핵심은 생산 속도와 소비 속도가 다를 때 안정적으로 데이터를 주고받는 것

- 멀티 프로세스와 멀티 스레드의 차이점과 각각의 장단점에 대해 설명해라.

- 멀티 스레드

- 장점

- 메모리 공유: 같은 프로세스 내에서 스레드들이 메모리를 공유해서 데이터 교환이 빠르고 효율적이야

- 빠른 생성/전환: 스레드 생성과 컨텍스트 스위칭이 프로세스보다 훨씬 빨라

- 리소스 효율성: 메모리 사용량이 적고 시스템 리소스를 덜 소모해

- 응답성: GUI 애플리케이션에서 UI 스레드와 작업 스레드를 분리해서 사용자 경험이 좋아져

- 단점

- 동기화 문제: Race condition, 데드락 같은 동시성 문제가 발생할 수 있어

- 디버깅 어려움: 버그 재현이 어렵고 디버깅이 복잡해

- 안정성: 한 스레드가 크래시하면 전체 프로세스가 영향받을 수 있어

- 복잡성: 공유 자원 관리를 위한 락, 세마포어 등의 동기화 메커니즘이 필요해

- 장점

- 멀티 프로세스

- 장점

- 안정성: 프로세스 간 격리되어 있어서 한 프로세스가 죽어도 다른 프로세스에 영향 없어

- 확장성: 여러 CPU 코어를 완전히 활용할 수 있어 (진정한 병렬 처리)

- 보안: 프로세스 간 메모리가 분리되어 있어서 보안이 더 좋아

- 단순함: 프로세스 간 간섭이 적어서 설계가 상대적으로 단순해

- 단점

- 무거움: 프로세스 생성과 컨텍스트 스위칭 비용이 커

- 메모리 오버헤드: 각 프로세스마다 독립적인 메모리 공간을 가져야 해서 메모리 사용량이 많아

- 통신 복잡성: IPC(Inter-Process Communication)를 통해 데이터를 주고받아야 해서 복잡하고 느려

- 리소스 소모: 시스템 리소스를 많이 사용해

- 장점

- 멀티 스레드

- 멀티프로세스와 멀티스레드의 장단점과 어떤 상황에서 사용해야 하는가?

- 멀티 프로세스는 CPU 집약적 작업에 효율적이다.

- 완전한 병렬 처리

- 독립적인 계산 및 동일 작업을 여러 데이터에 진행할 때 (수학 연산, 이미지 처리 등)

- 멀티 프로세스는 cpu의 각 코어마다 할당하여 연산작업을 수행할 수 있다.

- 멀티 스레드도 특정 코어에 고정할 수는 있지만 메모리 공유와 언어별 제약으로 인해 한계가 존재한다.

- 캐시 일관성 문제 (스레드의 경우 메모리를 공유하기 때문에 여러 코어가 메모리를 수정할 경우 캐시 일관성 문제가 발생할 수 있음.)

- False Sharing 또는 캐시미스 발생

- False Sharing: 서로 다른 스레드가 독립적인 데이터를 사용하는데도, 같은 캐시 라인에 위치해서 불필요한 캐시 무효화가 발생하는 현상

- 메모리 대역폭 경합 (각 스레드가 동일한 메모리 영역을 접근하려고 하기 때문, 멀티 프로세스는 각 프로세스가 독립적인 메모리 영역을 접근하기 때문에 캐시 히트율이 높음.)

- 멀티 스레드도 특정 코어에 고정할 수는 있지만 메모리 공유와 언어별 제약으로 인해 한계가 존재한다.

- 완전한 병렬 처리

- 멀티 스레드는 I/O Bound 작업이 많을 때 효율적이다.

- I/O 대기시간을 활용: 한 스레드가 대기중일 때 다른 스레드가 CPU 사용

- 빠른 컨텍스트 스위칭: I/O 완료 시 즉시 다른 스레드로 전환

- 메모리 효율성: 프로세스보다 훨씬 적은 메모리 사용

- 간단한 데이터 공유: 캐시, 연결 풀 등을 쉽게 공유

- 멀티 프로세스는 CPU 집약적 작업에 효율적이다.

- IO Bound

- I/O Bound는 프로세스가 진행될 때, I/O Wating 시간이 많은 경우다. 파일 쓰기, 디스크 작업, 네트워크 통신을 할 때 주로 나타나며 작업에 의한 병목(다른 시스템과 통신할 때 나타남)에 의해 작업 속도가 결정된다.

I/O Bound의 경우에는 CPU 성능보다 타 시스템과의 병목 부분(I/O Wating)에 큰 영향을 받기 때문에 스레드 개수를 늘리거나 동시성을 활용한다. 따라서 성능 향상을 위해 scale-out을 주로 사용한다.

- IO의 종류

- Storage IO (저장장치의 입출력)

- 특성: 지속성, 용량 큼, 속도 상대적으로 느림

- Disk IO: HDD, SSD 읽기/쓰기

- File IO: 파일 시스템 작업

- Database IO: DB 쿼리, 트랜잭션

- Cache IO: 디스크 캐시 접근

- 특성: 지속성, 용량 큼, 속도 상대적으로 느림

- Network IO (네트워크 입출력)

- 특성: 원격 통신, 지연시간 큼, 대역폭 제한

- Socket IO: TCP/UDP 통신

- HTTP IO: 웹 요청/응답

- API IO: REST, GraphQL 호출

- RPC IO: 원격 프로시저 호출

- 특성: 원격 통신, 지연시간 큼, 대역폭 제한

- Memory IO (메모리 입출력)

- 특성: 매우 빠름, 휘발성

- RAM Access: 메모리 읽기/쓰기

- Cache IO: L1/L2/L3 캐시 접근

- Virtual Memory: 페이징, 스왑

- Memory Mapping: mmap() 연산

- 특성: 매우 빠름, 휘발성

- Device IO (장치 입출력)

- 특성: 하드웨어 종속적, 드라이버 필요

- 입력 장치

- Keyboard IO: 키보드 입력

- Mouse IO: 마우스 이벤트

- Touch IO: 터치스크린

- Sensor IO: 온도, 압력 센서

- 출력 장치

- Display IO: 모니터 출력

- Printer IO: 프린터 출력

- Speaker IO: 오디오 출력

- Inter-Process IO (프로세스간 통신)

- 특성: 프로세스간 데이터 교환

- Pipe IO: 파이프 통신

- Message Queue: 메시지 큐

- Shared Memory: 공유 메모리

- Signal IO: 시그널 처리

- 특성: 프로세스간 데이터 교환

- Graphics IO (그래픽 입출력)

- 특성: GPU 사용, 대용량 데이터

- GPU IO: 그래픽 카드 통신

- Video IO: 비디오 스트림

- Texture IO: 텍스처 로딩

- Frame Buffer: 화면 버퍼 작업

- Audio IO (오디오 입출력)

- 특성: 실시간 처리, 지연 민감

- Microphone IO: 마이크 입력

- Speaker IO: 스피커 출력

- Audio File IO: 오디오 파일 처리

- Streaming IO: 실시간 오디오 스트림

- 특성: 실시간 처리, 지연 민감

- Serial IO (직렬 통신)

- 특성: 순차적 데이터 전송

- UART IO: 시리얼 포트

- USB IO: USB 장치 통신

- Bluetooth IO: 블루투스 통신

- I2C/SPI: 하드웨어 버스

- 특성: 순차적 데이터 전송

- Storage IO (저장장치의 입출력)

- 성능 비교 (대략적 속도)

IO 종류 지연시간 대역폭 CPU Cache 1ns 100GB/s RAM 100ns 50GB/s SSD 0.1ms 3GB/s HDD 10ms 200MB/s Network (LAN) 0.5ms 1GB/s Network (Internet) 50ms 100MB/s - CPU Bound

- CPU Bound는 프로세스가 진행될 때, CPU 사용 기간이 I/O Wating 보다 많은 경우다. 주로 행렬 곱이나 고속 연산을 할 때 나타나며 CPU 성능에 의해 작업 속도가 결정된다.

- CPU의 성능이 향상되거나 개수가 추가되면 CPU Bound의 작업 처리 성능이 향상된다. 따라서 성능 향상을 위해 scale-up이 주로 사용된다.

IPC (Inter Process Communication)

- IPC (Inter Process Communication)

- 메시지 큐

- 최대 메시지 크기: 보통 8KB

- 큐딩 최대 메시지 수: 보통 10개

- 시스템 전체 최대 큐 수: 보통 16개

- 공유 메모리 (Shared Memory)

- 최대 세그먼트 크기: 보통 32MB

- 시스템 전체 최대 세그먼트 수 : 보통 4096개

- 세마포어

- 세마포어 집합 당 최대 세마포어 수 : 보통 250개

- 시스템 전체 최대 세마포어 집합 수 : 보통 128개

- 파이프

- 파이프 버퍼 크기 : 보통 64KB

- Linux에서 이 정보들을 확인하려면 /proc/sys/kernel/ 의 정보들을 살펴보면 된다.

- 소켓 (Unix Domain Socket)

- 같은 시스템 내에서 통신하는 소켓

- 네트워크를 거치지 않고 커널 내부에서 동작함.

- SOCK_STREAM (TCP처럼 연결지향, 순서 보장)

- SOCK_DGRAM (UDP처럼 데이터그램 방식)

- UDS (Unix Domain Socket) 이 네트워크 통신보다 빠른 이유

- 네트워크 스택 우회

- TCP: 애플리케이션 → 소켓 계층 → TCP 계층 → IP 계층 → 네트워크 드라이버 → 루프백 → 다시 역순

- UDS: 애플리케이션 → 소켓 계층 → 커널 내부 버퍼 → 바로 상대방

- 패킷 처리과정 생략

- TCP: 헤더 추가/제거, 체크섬 계산, 시퀀스 번호 관리

- UDS: 단순한 메모리 복사만

- 체크섬: 메모리 ECC + 커널 보장

- 순서보장: 커널 FIFO 버퍼

- 재전송 불필요

- 흐름제어: 커널 버퍼 크기

- 네트워크 오버헤드 없음

- IP/TCP 헤더 없음 (보통 40 + bytes)

- 네트워크 대역폭 제한 없음

- 패킷 손실/재전송 걱정 없음

- 컨텍스트 스위칭 최소화

- 같은 커널공간에서 처리

- 커널이 네트워크 프로토콜 스택을 우회함.

- 인터럽트 처리 불필요

- 같은 커널공간에서 처리

- 네트워크 스택 우회

- 커널이 직접 관리하는 IPC들

- System V IPC (MQ, Shared Memory, Semaphore)

- Pipe

- Socket

- Signal

- 사용자 공간에서 관리되는 IPC

- D-Bus

- 사용자 맵 파일 (mmap으로 만든 공유 영역)

- 사용자 레벨 메시지 패싱 라이브러리들

- IPC 방식에 따라 대역폭이 대략적으로 다르다.

- 공유메모리 (50~100GB/s) (1 micro second)

- User A → Shared Memory ← User B (직접 접근)

- 복사 횟수 0

- 장점

- 엄청난 성능

- 단점

- 복잡한 동기화

- 에러 처리 지옥

- 개발/유지보수 비용 증대

- 디버깅 어려움

- 메모리 매핑 (40~80GB/s) (5 micro second)

- UDS (15~25GB/s) (50 micro second)

- User A → Kernel → Socket Buffer → Kernel → User B

- 복사 횟수 2번 (User→Kernel→User)

- TCP 루프백 (10~15GB/s) (100 micro second)

- User A → Kernel → Network Stack → TCP → IP → Loopback → IP → TCP → Kernel → User B

- 복사 횟수 4번 (User→Kernel→Network→Kernel→User)

- POSIX MQ (1~5GB/s) (200 micro second)

- 메시지 크기제한 8KB 기본

- 우선순위 큐를 사용함.

- 일반 큐가 아니라 우선순위 큐를 사용하는 이유

- 실시간 시스템의 필수 요소 (긴급 상황, 데이터에 대한 우선순위 처리 가능)

1 2 3 4 5 6

enum message_priority { PRIORITY_EMERGENCY = 31, // 심장 정지 알람 PRIORITY_CRITICAL = 20, // 혈압 위험 PRIORITY_WARNING = 10, // 일반 경고 PRIORITY_INFO = 0 // 상태 정보 };

- 시스템 제어 vs 데이터 분리

- QoS (Quality of Service) 구현

- QoS: 네트워크에서 트래픽을 우선순위를 정해서 중요한 데이터를 먼저 보내거나 더 죻은 품질로 전송하는 기술

- 시스템 제한 늘려서 대역폭 개선 가능

1 2 3 4

# /etc/sysctl.conf 또는 런타임 설정 echo 1000 > /proc/sys/fs/mqueue/msg_max # 메시지 개수 echo 65536 > /proc/sys/fs/mqueue/msgsize_max # 64KB로 증가 echo 1024 > /proc/sys/fs/mqueue/queues_max # 큐 개수

- System V MQ (0.5~3GB/s) (300 micro second)

- 메시지 크기제한 4KB 기본

- 메시지 구조가 POSIX MQ보다 더 무거움

- 장점

- 레거시 시스템과의 호환성

- 메시지 타입 필터링의 강력함

- 더 세밀한 권한 제어

- 시스템 전역 가시성

- 특수한 고급 기능들

- 공유메모리 (50~100GB/s) (1 micro second)

- 메시지 큐

- POSIX MQ가 UDS, SharedMemory보다도 성능이 느린데.. 왜 그렇지?

- ex) 8kb 데이터를 1억개 전송한다고 가정해봅시다.

- 메모리 할당/해제 오버헤드

- UDS: 미리 할당된 sk_buff 재사용해서 추가 할당하지 않음.

- (하지만 shared memory에 비해서 데이터 복사는 일어날 수 있다. 이것으로 인해 shared memory보다 대역폭이 떨어짐.)

- POSIX MQ: 1억번의 kmalloc/kfree

- UDS: 미리 할당된 sk_buff 재사용해서 추가 할당하지 않음.

- 메타데이터 처리 오버헤드

- UDS: 거의 순수 데이터

- POSIX MQ: list_head 포인터, m_type, proiroty 등, 52byte 정도의 플래그가 존재해 오버헤드

- 메시지 당 52byte * 1억개 : 약 5GB의 추가 메타데이터

- 우선순위 처리 오버헤드 (1억번)

- 1억번의 우선순위 정렬 발생

- 메모리 압박 문제

- 1억 개의 메시지가 동시에 존재할 경우

- UDS: 1000 * (sizeof(struct sk_buff) + 8192) // 1000개 정도만 유지

- POSIX MQ: 100000000 * (sizeof(struct msg_msg) + 8192) // 800GB

Memory Allocation

- malloc / free

- malloc과 free는 생각보다 무거운 연산임

- 일반적으로는 free가 더 무겁다. (대부분의 경우)

- 하지만 malloc도 상당한 오버헤드가 존재한다.

- 상황에 따라 차이가 크다.

- malloc이 하는 일 (50~100ns)

- 적절한 크기의 청크 찾기

- 필요 시 청크 분할

- 메타데이터 설정

- free가 하는 일 (80~300ns)

- 포인터 유효성 검사

- 시스템 안정성 보호

- 잘못된 포이터 해제 시, 자유 리스트 조작 및 리스트 구조 파괴하여 전체 힙 구조가 붕괴되고 시스템이 크래시됨.

- 따라서 최소한의 일관성을 체크

- 포인터 정렬 검사

- 청크 크기 일관성 검사

- 사용중인 청크인지 확인

- 포인터 유효성 검사를 한다면 왜 해제된 포인터 또는 잘못된 포인터를 free 할 때 죽는가?

- 제한적인 검사만 하기 떄문이다.

- 완전한 검사를 하지 않는다.

- 성능상의 문제

- 완전한 유효성 검사를 하려면 모든 할당된 청크들을 순회해야 한다.

- 메모리 레이아웃의 한계

- 메모리 할당자는 힌트만 가지고 있다.

- 이전 청크 크기, 현재 청크 크기 + 플래그들 (이것만으로는 완전한 검증을 할 수가 없다.)

- 성능상의 문제

- 시스템 안정성 보호

- 인접 청크들과 병합 <- 가장 무거움

- 메모리 단편화 방지가 핵심

- 병합하지 않으면

- 100바이트씩 5개 할당

- 2번째 4번째 해제 (병합 없이)

- 200바이트 자유공간이 있지만, 100바이트로 나누어져 있어 차웋 200byte 할당 필요 시 할당 불가.

- 연속된 200byte가 없고 100byte 두개로 나뉘어져 있기 때문임

- 적절한 자유 리스트에 삽입 <- 정렬 필요

- 빠른 재할당을 위한 자료구조

- 자유 리스트가 없다면 매번 malloc 시 전체 힙을 스캔해야 함.

- 크기별 분류로 최적화

- Fast bins (16-80 bytes) - LIFO 스택

- Small bins (< 1024 bytes) - 크기별 더블 링크드 리스트

- Large bins (>= 1024 bytes) - 크기+주소 정렬 트리

- 메모리 지역성 최적화

- 빠른 재할당을 위한 자료구조

- 큰 메모리는 시스템이 반환

- 큰 메모리의 기준

- glibc의 기본 임계값 128kb

- 128kb 이상은 즉시 반환해서 시스템 압박 완화

- 128KB 이상 = mmap 시스템 콜 사용 (이 mmap은 파일 매핑 mmap이 아니라 익명 mmap이다.)

- 왜 128KB가 기본 크기일까?

- 페이지 크기 고려

- 일반적인 페이지 크기: 4KB

- 128KB = 32 페이지 = 합리적인 단위

- 시스템 콜 오버헤드

- mmap/munmap: ~1000 cycle

- 작은 메모리에는 비용 대비 효과 부족

- 메모리 단편화 밸런스

- 너무 작으면: 힙 단편화 심각

- 너무 크면: 메모리 낭비 심각

1 2 3 4

// glibc malloc의 기본 설정 #define DEFAULT_MMAP_THRESHOLD (128 * 1024) // 128KB #define MAX_MMAP_THRESHOLD (512 * 1024) // 512KB #define MIN_MMAP_THRESHOLD (0)

- 페이지 크기 고려

- 메모리 압박 상황 대응

- 큰 메모리를 계속 보유한다면?

- 1GB 메모리 할당 후 잠깐 사용한 뒤 해제

- 할당자가 1GB를 계속 보유한다면?

- 다른 프로세스가 메모리 부족으로 고생

- 시스템 전체 성능 저하

- OOM Killer (Out Of Memory Killer)가 이 프로세스를 죽일수도..

- 하지만 시스템에 반환하면?

- 다른 프로세스가 사용 가능

- 시스템 메모리 압박 완화

- 큰 메모리를 계속 보유한다면?

- 가상 메모리 시스템과의 협력

- 큰 메모리의 기준

- 포인터 유효성 검사

- free가 더 무거운 이유

- 메모리 병합 (인접 청크 합치기)

- 자유 리스트 관리 (크기별 정렬 삽입)

- 포인터 유효성 검사

- 시스템 메모리 반환 (큰 블록)

- 최적화 방법

- 메모리 풀 사용 (커넥션 풀 처럼 메모리를 미리 할당해두고 필요할 때마다 사용)

- 배치 할당/해제

- 고성능 할당자 (jemalloc)

- 객체 재사용

Valgrind 원리

- Valgrind가 메모리를 검사하는 방법

- 바이너리를 가상머신에서 실행함.

- 모든 메모리 접근을 인터셉트

- Shadow memory 를 사용해서 각 바이트의 상태를 추적

- 실제 메모리와 1:1 대응되는 그림자 메모리를 유지

- 실제 메모리 1바이트당 그림자 메모리 1비트 사용

- 모든 malloc / free를 추적해서 테이블에 기록

- 10~100배 느려짐

- Address Sanitizer

- 컴파일 타임에 코드를 변경

- Shadow memory 사용

- Red zones 삽입

- malloc 시 앞뒤로 레드존 추가

- 버퍼 오버플로우 시 레드존 접근으로 즉시 감지

- 2~3배 느려짐

- 런타임에 체크

mmap

- mmap

- 파일 매핑 mmap

- 첫 접근 (Cold)

- 🐌 디스크 속도 (HDD: ~100MB/s, SSD: ~500MB/s)

- ⏱️ 레이턴시: HDD 10ms, SSD 0.1ms

- 재접근 (Warm)

- 🚀 RAM 속도 (~50GB/s)

- ⏱️ 레이턴시: ~100ns

- 핵심 포인트

- 🔄 지연 로딩: mmap 호출은 즉시, 실제 읽기는 접근 시

- 💾 페이지 캐시: 한번 읽은 데이터는 RAM에 캐시

- 📈 접근 패턴: 순차 > 랜덤 (프리페칭 효과)

- 🎯 madvise: 힌트로 성능 최적화 가능

- 요약

- 처음엔 디스크 속도만큼 느림

- 이후엔 RAM 속도만큼 빠름

- 전체적으로는 read()보다 효율적 파일 매핑 mmap은 “스마트한 캐싱 시스템”이라고 보면 돼! 😄

- 디스크와 메모리를 1대1 매핑하는 함수

- 파일매핑 mmap의 메모리는 R/W 등이 디스크에 접근하고 쓰는 속도와 비슷한가?

- 처음에는 느리지만, 이후엔 빨라짐

- mmap의 지연 로딩, 페이지 캐시 때문에 생각보다 복잡함.

- 파일매핑 mmap의 메모리는 R/W 등이 디스크에 접근하고 쓰는 속도와 비슷한가?

- 접근 패턴에 따른 성능 차이도 존재함.

- 순차 접근이 랜덤 접근보다 빠름. (랜덤 접근은 캐시 미스 많음)

- 메모리 조언 (madvise) 활용

- lazy loading

- 즉시 접근하지 않음.

- 따라서 실제 접근할 때 페이지 폴트가 발생함.

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26

#include <sys/mman.h> #include <sys/stat.h> #include <fcntl.h> void mmap_lazy_loading_demo() { // 1GB 파일 생성 int fd = open("huge_file.dat", O_RDWR | O_CREAT, 0644); ftruncate(fd, 1024 * 1024 * 1024); // 1GB printf("1GB 파일 생성 완료\n"); // 파일 매핑 - 즉시 실행됨! struct timespec start, end; clock_gettime(CLOCK_MONOTONIC, &start); char *mapped = mmap(NULL, 1024 * 1024 * 1024, PROT_READ | PROT_WRITE, MAP_SHARED, fd, 0); clock_gettime(CLOCK_MONOTONIC, &end); double mmap_time = (end.tv_sec - start.tv_sec) + (end.tv_nsec - start.tv_nsec) / 1e9; printf("1GB mmap 호출 시간: %.6f초 (매우 빠름!)\n", mmap_time); printf("왜? 아직 실제로는 디스크에서 아무것도 안 읽었거든!\n"); close(fd); }

- page cache

- 커널의 페이지 캐시 시스템

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22

// 커널 관점에서 mmap 페이지 폴트 처리 (의사코드) void handle_mmap_page_fault(void *virtual_addr, struct vm_area_struct *vma) { // 1. 가상 주소를 파일 오프셋으로 변환 off_t file_offset = vma->vm_pgoff + ((virtual_addr - vma->vm_start) >> PAGE_SHIFT); // 2. 페이지 캐시에서 확인 struct page *page = find_page_in_cache(vma->vm_file, file_offset); if (page) { printf("캐시 히트! RAM에서 즉시 반환\n"); // 페이지 테이블에 매핑만 추가 map_page_to_process(page, virtual_addr); } else { printf("캐시 미스! 디스크에서 읽어야 함\n"); // 디스크에서 읽기 page = read_page_from_disk(vma->vm_file, file_offset); // 페이지 캐시에 저장 add_page_to_cache(page); // 프로세스에 매핑 map_page_to_process(page, virtual_addr); } }

- 커널의 페이지 캐시 시스템

- virtual memory

- 첫 접근 (Cold)

- 익명 mmap (malloc 으로 큰 메모리 할당할 때에도 이 익명 mmap을 사용함)

- 가상 메모리 영역 할당

- 물리 페이지와의 연결

- 페이지 테이블 설정

1 2 3 4 5 6 7 8 9 10 11 12 13

void lazy_allocation_demo() { // 1GB mmap 요청 char *huge = mmap(NULL, 1024*1024*1024, PROT_READ | PROT_WRITE, MAP_PRIVATE | MAP_ANONYMOUS, -1, 0); printf("1GB mmap 성공! 하지만 실제 메모리는 아직 안 씀\n"); // 실제 접근할 때 페이지 할당됨 (page fault) huge[0] = 'A'; // 첫 페이지만 실제 할당됨 huge[1024*1024*1024-1] = 'Z'; // 마지막 페이지 할당됨 printf("실제로는 2개 페이지(8KB)만 물리 메모리 사용!\n"); }

- 이런 코드로 인해 아래와 같은 상황에서는 실제로 1기가 메모리 사용함.

1 2 3 4 5 6

const int gib_1_size = 1024 * 1024 * 1024; char *ptr1 = (char *)malloc(gib_1_size); memset(ptr1, 0, gib_1_size); // 이런 경우에는 calloc이 효율적 char *ptr2 = calloc(1, gib_1_size);

- 왜 malloc/memset 보다 calloc이 더 빠른가?

malloc/memset은 memset으로 인해 1GiB 메모리를 모두 사용함.

- calloc은 MAP_ANONYMOUS 플래그로 인해 mmap된 메모리는 커널에서 자동으로 0으로 초기화해주기 때문

- mmap()으로 할당된 메모리는 이미 0으로 초기화되어 있음.

calloc은 이걸 알고 있어서 memset을 건너뜀.

- 하지만 작은 메모리 할당 해제에는 똑같다. (익명 mmap을 사용하지 않는 경우)

- calloc은 항상 0으로 초기화된 메모리르 반환함

- 사용자는 절대 추가 memset 필요 없음

- 내부적으로 구현 방식이 다름

- 작은 메모리: calloc이 내부에서 memset

- 큰 메모리: calloc이 memset 건너뜀

- 파일 매핑 mmap

- malloc : memory allocation

- calloc : contiguous allocation

realloc : resize allocation

- malloc vs calloc

-

malloc(400)- 400byte 줘 -

calloc(100, sizeof(int)),int (4byte)100개 할당해 줘 (배열 선언 등) - malloc: 메모리만 달라

- calloc: 0으로 초기화된 메모리 또는 배열을 달라

calloc은 큰 메모리에서 매우 효율적

- malloc은 성능 최적화 (불필요한 초기화 방지), 작은 할당 등에서 calloc보다 빠름.

- malloc: 구조체, 즉시 덮어쓸 데이터

calloc: 배열, 큰 메모리, 0 초기화 필요

- 둘 다 같은 가상 멤뢰 주소 공간을 사용하고, CPU 캐시 동작도 동일하기 때문에 접근성능 등에서의 차이는 없음.

-

파일 매핑 mmap vs read/write 함수

-

파일 매핑 mmap vs read/write 함수

- mmap의 함정들

- 작은 파일에서는 오히려 느림

- ex) 12byte 파일 읽기 (12byte를 위해 mmap에서는 4096 bytes 페이지를 할당해야 하기 떔누에 오버킬)

- 메모리 압박 문제

- 1기가 파일을 읽는다고 가정할 때

- read() 방식: 필요한 만큼만 읽기

- 메모리 사용: 64KB (버퍼 크기만큼)

- mmap() 방식: 전체 파일 매핑

- mmap 방식을 사용하면 가상메모리 1GB 사용

- 실제 물리 메모리: 접근한 페이지만

- 가상공간을 1GB씩이나 소모

- read() 방식: 필요한 만큼만 읽기

- 1기가 파일을 읽는다고 가정할 때

순차 읽기에서는 read가 더 효율적

- read가 더 좋은 상황

- 작은 파일 (< 4KB)

- 스트리밍 처리

- 네트워크나 파이프 입력

- 에러 처리의 명확성 (에러 처리가 중요한 경우)

- 포터빌리티와 호환성 -포터빌리티 문제?

- 파일 크기를 모르는 경우

- 메모리가 부족한 환경

- mmap 사용이 좋은 경우

- 큰 파일

- 랜덤 접근이 많은 경우

- 파일의 일부만 자주 접근

- 여러 프로세스가 공유

- 메모리 매핑된 자료구조

- 지연 로딩이 유리한 경우

- 파일과 메모리 동기화가 필요한 상황

- ex) 대용량 데이터페이스

- 작은 파일에서는 오히려 느림

- mmap의 함정들

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

높은 주소

┌─────────────────┐

│ 스택 │ ← 지역변수, 함수 호출

├─────────────────┤

│ ↕ │ ← 스택/힙 사이 빈 공간

├─────────────────┤

│ mmap 영역 │ ← mmap(), 공유 라이브러리

│ (Memory Mapping)│ 큰 malloc 할당

├─────────────────┤

│ ↕ │

├─────────────────┤

│ 힙 영역 │ ← 작은 malloc 할당

│ (heap) │ sbrk/brk로 확장

├─────────────────┤

│ 데이터 영역 │ ← 전역변수, 정적변수

├─────────────────┤

│ 텍스트 영역 │ ← 프로그램 코드

└─────────────────┘

낮은 주소

sbrk/brk

- sbrk/brk?

- 힙 영역의 크기를 조절하는 시스템 콜

program break: 힙 영역의 끝 지점을 가리키는 포인터

- 핵심: sbrk/brk는 연속된 힙 메모리 공간을 만들어주는 도구. mmap처럼 여기저기 흩어진 게 아니라 한 덩어리로 쭉 이어진 메모리를 관리 이로 인해 작은 malloc들이 메모리 단편화 없이 효율적으로 관리될 수 있음.

- brk vs sbrk

- brk (void addr)

- sbrk (intptr_t increment)

- brk

1 2 3

#include <unistd.h> // 힙의 끝을 특정 주소로 설정 brk(new_end_address); // 절대 위치 설정

- sbrk

1 2 3 4 5

#include <unistd.h> // 현재 위치에서 상대적으로 증가/감소 void *old_brk = sbrk(1024); // 1024바이트 증가 void *current = sbrk(0); // 현재 위치만 확인 sbrk(-512); // 512바이트 감소

- malloc과의 관계

1 2 3 4 5 6 7 8 9 10 11

// malloc 내부에서 이런 식으로 동작 void* my_malloc(size_t size) { void *current_brk = sbrk(0); // 힙 공간이 부족하면 if (need_more_space) { sbrk(size); // 힙 확장 } return allocated_pointer; }

익명 mmap

- 익명 mmap (큰 메모리)

- mmap, munmap 시스템 콜 등이 추가로 필요해 malloc에 비해 상대적으로 느림.

- 시스템 콜 오버헤드 (매번 커널모드 전환 필요 -> 느림)

- 외부 단편화 발생 가능성 (가상 주소 공간 파편화)

- munmap() 으로 free 시 즉시 OS에 반납

- mmap, munmap 시스템 콜 등이 추가로 필요해 malloc에 비해 상대적으로 느림.

- malloc (작은 메모리)

- 할당 해제 성능이 빠름

- 사용자 공간에서 처리되어 할당/해제 처리가 빠름.

- malloc: 빠름, 기존 heap 영역에서 블록을 찾기 때문

- free: heap 내부 관리로 인해 빠름.

- 내부 단편화 가능, 하지만 관리됨.

- free 해도 즉시 OS에 반납 안함. (재사용을 위해 보관됨.)

- 이로 인해 시스템 콜 호출이 절약됨.

- 처음 malloc 호출

- heap이 비어 있으면 brk() 또는 sbrk() 시스템 콜로 heap 확장

- 보통 128KB 정도 미리 확보

- 처음 malloc 호출

- 이후 malloc 호출들

- 기존 heap 영역 내에서 블록 찾기/분할

- 시스템 콜 없음.

- 이후 malloc 호출들

- heap 공간 부족 시

- 다시 brk() 시스템 콜로 heap 확장

- heap 공간 부족 시

- free() 동작 시

- 내부 자료구조만 업데이트

- 메모리를 heap 풀에 반환 (OS에는 반환 안함.)

- free() 동작 시

- 큰 영역 정리 시

- 많은 free 이후 heap이 상당히 비워지면

- malloc_trim () 등으로 OS에 일부 반환 -> 시스템 콜

- M_TRIM_THRESHOLD 기본값 128KB

- heap의 최상단 (top-most)에 있는 해제 가능한 청크가 128KB 이상이면

- 시스템 콜 (brk(), sbrk() 등을 호출해서 메모리를 OS에 반환)

- 주요 특징

- top-most 청크만 해당

- heap 중간의 빈 공간은 상관없음

- heap 끝부분의 연속된 빈 공간만 계산

- 이 값은 프로그램 패턴에 따라 동적으로 조절되며, 수동으로 설정하면 동적 조절 비활성화

- 프로그램에서 큰 메모리를 해제할 때

- 해제된 chunk 크기가 현재 mmap_threshold 보다 크면

- mmap_threshold를 그 크기로 증가시킴

- 동시에 trim_threshold는 mmap_threshold의 2배로 설정

- 왜 이렇게 설계?

- 큰 메모리를 자주 사용하는 프로그램이라면

- mmap_threshold를 높여서 heap 에서 할당하게 하고

- trim_threshold도 높여서 heap을 자주 축소하지 않게 함.

- 이렇게 성능 최적화 - 환경 변수로도 설정할 수 있다

- 큰 영역 정리 시

- 이로 인해 시스템 콜 호출이 절약됨.

- 할당 해제 성능이 빠름

32bit 운영체제의 메모리 제한

- 32Bit 운영체제의 메모리는 4GiB까지밖에 사용할 수 없다. 그 이유는?

- 포인터가 32Bit (4Byte) 까지밖에 표현할 수 없어 그 이상의 메모리를 사용할 수 없다.

- 말했던 4byte 포인터가 애플리케이션 레벨에서 말한 포인터인가? (물리주소가 정답)

- 애플리케이션 레벨 (가상주소) 에서 4Byte 까지밖에 표현할 수 없다. 라고 말하면, 각 어플리케이션마다 4GiB를 표현할 수 있다 라는 것이기 때문에 이는 오류임. (가상주소를 통해 실제 RAM 공간보다 더 많은 메모리 적재가 가능하기 때문)

- 가상주소: 프로그램에서 사용하는 주소 (메모리 보호와 프로세스간 독립성 제공) (이런 가상 주소 (가상메모리)가 있기 때문에 실제 RAM 공간보다 더 많은 메모리 적재가 가능하다.)

- 물리주소: 실제 RAM에 있는 메모리 주소, 가상 주소는 물리 주소로 변환됨.

- 주소변환: 가상주소를 물리주소로 변환하는 과정, CPU의 메모리 관리 유닛에 의해 변환됨.

- 페이지 테이블: 가상주소와 물리주소 간의 매핑 정보를 저장하는 데이터 구조. 페이지 테이블을 사용해 가상 주소를 물리 주소로 변환함.

numpy

- numpy 벡터 연산, 이것이 C/Rust보다 빠른 이유는 무엇인가?

- 일단 numpy 자체가 C로 구현됨. (C/C++/Fortran 으로 작성됨.)

- 벡터화의 위력

- SIMB 최적화 (CPU의 SIMB 명령어를 통해 한 번에 여러 데이터를 처리. ex: 4개의 float 를 동시 곱셈)

- 메모리 접근 최적화 (연속된 메모리 블록에서 효율적인 데이터 R/W, 캐시 미스를 최소화하는 메모리 레이아웃)

- 고도로 최적화된 라이브러리

- BLAS 같은 검증된 수학 라이브러리

- Intel MKL, OpenBLAS 같은 최적화 백엔드 사용

✅ numpy가 유리한 경우

- 대용량 배열 연산

- 수학적 연산 (행렬 곱셈, 통계 함수 등)

- 전체 배열에 대한 연산 ❌ 직접 C/Rust가 더 좋은 경우

- 복잡한 조건문이 많은 로직

- 메모리 사용량이 중요한 경우

- 매우 특화된 알고리즘

- 작은 데이터셋

Sort (정렬 알고리즘)

- 버블/삽입 정렬과 같은 O(n^2) 정렬 알고리즘보다 효율적인 알고리즘을 말해보아라.

- 퀵소트와 머지소트

- 퀵소트의 시간복잡도

- 퀵소트의 평균/ 최악 시간복잡도는 몇인가?

- 평균: O(n log n)

- 최악: O(n^2)

- 또한 퀵소트는 메모리의 지역성을 잘 활용하는 알고리즘이라 타 알고리즘 대비 훨씬 빠르다.

- 퀵소트는 다른 소트 알고리즘과 다르게 메모리를 적게 사용한다고 했다. 그 이유는?

- in-place 정렬 알고리즘이기 때문

- 두 원소의 위치만 바꾸는 swap 연산만 사용함.

- 공간복잡도 평균 O(log n), 최악 O(n)

- in-place 정렬 알고리즘이기 때문

- Pivot이 3개가 있으면 더 느려질까/빨라질까/똑같을까?

- 최악 시나리오를 개선, 캐시 지역성 향상, 중복 값에 대한 스킵으로 인해 처리능력 증가 등으로 인해 더 안정성있는 동작을 보장할 수 있다.

- -> 일반적으로 비슷하거나, 더 빨라짐! 번외

- 배열

- 퀵소트

- 힙소트 (퀵소트의 최악 케이스보다 안정적)

- 리스트

- 머지소트 (순차 접근만 가능한 리스트에 최적화)

- 삽입정렬 (작은 리스트) 분할 방식

- 머지소트: 배열을 반으로 균등 분할 → 정렬 후 합병

- 퀵소트: 피벗 기준으로 크기별 분할 → 분할 자체가 정렬 시간복잡도

- 머지소트: 항상 O(n log n) - 안정적!

- 퀵소트: 평균 O(n log n), 최악 O(n²) 공간복잡도

- 머지소트: O(n) - 합병용 임시 배열 필요

- 퀵소트: 평균 O(log n) - in-place 정렬 머지소트 장단점 장점: ✅ 시간복잡도가 항상 O(n log n)으로 안정적 ✅ 안정 정렬 (같은 값의 상대적 순서 보존) ✅ 외부 정렬에 적합 (큰 데이터셋) ✅ 성능 예측 가능 단점: ❌ O(n) 추가 메모리 필요 ❌ 작은 배열에서는 오버헤드 ❌ 캐시 효율성 낮음 퀵소트 장단점 장점: ✅ 평균적으로 가장 빠름 ✅ in-place 정렬로 메모리 효율적 ✅ 캐시 친화적 ✅ 실제 성능이 뛰어남 단점: ❌ 최악의 경우 O(n²) ❌ 불안정 정렬 ❌ 피벗 선택에 따라 성능 차이 큼 ❌ 재귀 깊이가 깊어질 수 있음 언제 뭘 써야 할까? 머지소트 추천: 안정 정렬이 필요할 때 최악의 경우에도 성능 보장이 필요할 때 외부 정렬이나 링크드 리스트 정렬 퀵소트 추천: 일반적인 배열 정렬 (평균 성능 최고) 메모리가 제한적일 때 캐시 효율성이 중요할 때

- 퀵소트와 머지소트

- CORS 가 무엇인가?

- XSS와 CSRF 등의 공격을 방지 (위변조된 페이지 접근을 막아 보안을 향상)

- CORS 상황을 겪어보았나?

- Access-Control-Allow-Origin 헤더 세팅, 쿠키를 사용할 경우

Access-Control-Allow-Credentials: true필수

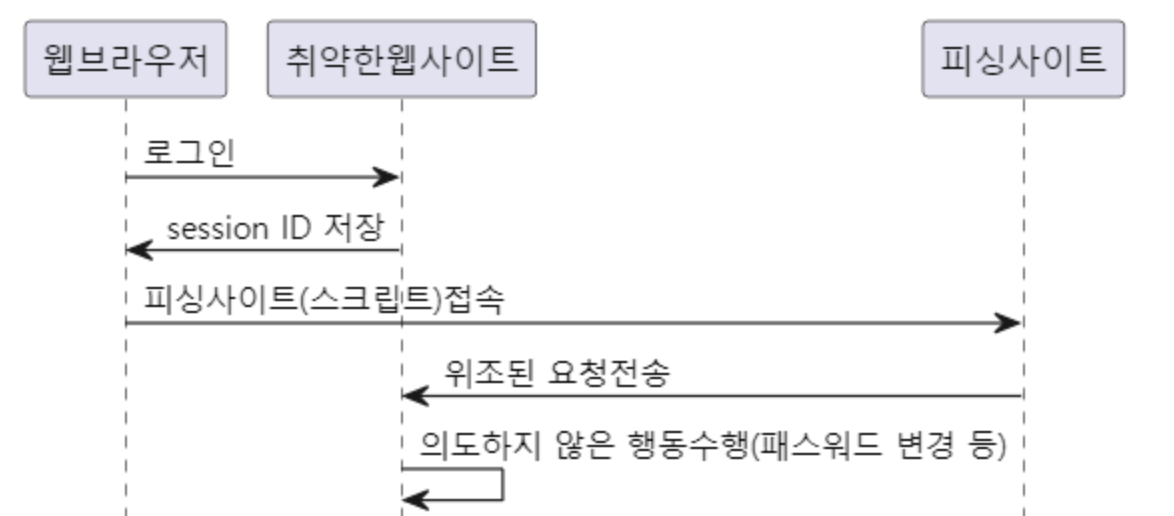

CSRF (Cross-Site Request Forgery)

- CSRF Cross-Site Request Forgery

- 사이트 간 요청 위조의 줄임말.

아래 공격 방식이 CSRF 공격

인코딩

- 바이너리 데이터라는 것은 정확히 어떤 의미인가?

- 바이너리 데이터는 문자 데이터가 아닌 데이터를 의미한다.

- 문자도 크게 보면 바이너리의 일종이다.

-

A문자 -> 65 (Ascii)-> 01000001,A라는 문자를 입력하면, 실제로는01000001이라는 바이너리 데이터를 전달하는 것이다.

-

- 키보드로 입력할 수 있는 것들을 문자 데이터 (abcdefg…ABCD… 12345… !@#$% …) 라고 암묵적인 약속을 하고 있다.

- 바이너리 데이터는 문자 데이터가 아닌 데이터를 의미한다. 단순히 말하면 키보드로 입력하지 못하는 문자(제어 문자

\0- 널 문자 등)를 의미한다.

- 한글은 2바이트인가?

- 정답: 그럴수도 있고, 아닐수도 있다. -> 모범 정답: 인코딩의 방식에 따라 다르기 때문에, 알 수 없다.

- EUC-KR 인코딩을 사용한다면, 한글은 2바이트가 맞다.

- 그러나 UTF-8 인코딩을 사용한다면, 한글은 3바이트이다.

- 유니코드 체계에서는 완성형이라 할 수 있는 현대 한글 11,172자와 (공식적인 명칭은 한글 음절, Hangul Syllables) 조합형처럼 쓸 수 있는 한글 초중종성이 (공식 명칭은 한글 자모, Hangul Jamos) 옛한글까지 모두 포함되어 있어서 두 방식 모두 사용이 가능하다.

- Base64 인코딩이란?

- 유니코드 인코딩이란?

- 유니코드는 전 세계의 모든 문자를 다루도록 설계된 문자 인코딩 표준이다.

- UTF-8, UCS 등 다양한 인코딩 방식이 있다.

- 즉 UTF-8도 유니코드 인코딩의 일종이다.

- 유니코드 인코딩이란?

- UTF-8 인코딩이란?

- UTF-8이 가변 데이터인 것을 어떻게 알지?

- 아래와 같이 첫 번째 헤더의 1내용을 가지고 가변길이 체크 가능

- 두 번째 헤더부터는

10으로 시작하여 가변길이인 것을 확인- (000000-00007F)

0xxxxxxx - (000080-0007FF)

110xxxxx, 10xxxxxx - (000800-00FFFF)

1110xxxx, 10xxxxxx, 10xxxxxx - (010000-10FFFF)

11110xxx, 10xxxxxx, 10xxxxxx, 10xxxxxx

- (000000-00007F)

- 헤더의

110은,11-> 즉 2바이트 인코딩을 의미함. - 헤더의

1110은,111-> 즉 3바이트 인코딩을 의미함. - 헤더의

11110은,1111-> 즉 4바이트 인코딩을 의미함.

- UTF-8이 가변 데이터인 것을 어떻게 알지?

- 유니코드는 무엇이고 UTF-8은 무엇인가? (유니코드가 UTF-8을 의미하는 것인가? -> 아니다.)

- 유래

- 옛날옛적, 컴퓨터가 처음 세상에 나왔을 때, 영어와 몇가지 특수문자만 활용이 되었고, 이런 적은 문자를 컴퓨터에 저장하기 위해서 1byte(8bit)면 충분했다.(0~255) - ASCII 문자 시간이 흘러, 다른 국가의 언어들이 활용되었고, 해당 국가의 사람은 자신의 언어를 표시하고 싶어졌다. 그래서 1byte안에 임의대로 영어 대신에 자신의 나라 문자를 할당하여 사용하게 되었다. - 문자열셋의 춘추전국시대… 그러다, 인터넷이 발전되며 다른 나라 사람의 홈페이지를 들어갔더니 글자가 와장창 깨지는 상황이 발생한다. 호환이 되지 않는 것이다. 그리하여, 국제적으로 전세계 모든 언어를 표시할 수 있는 표준코드를 만들기로 하였다. 이것이 바로 유니코드(unicode)이다.

참고로, 한글

가는 유니코드로U+AC00이다. 왜냐고? 약속이라서.- UTF-8의 탄생

- 유니코드를 통해서 문자를 나타내는 코드는 정의되었다. 즉, 각 문자마다 인덱스가 정해졌다. 그럼 이 코드를 컴퓨터에 어떤 방식으로 저장할 것인가? 똑똑한 사람들이 인코딩하는 규칙을 정했는데, 그 중 한가지 방법이 UTF-8 방식이다. (UCS-2,UCS-4,UTF-32,UTF-16,UTF-8 등이 있음)

- 문자마다 적절한 바이트 수를 차지하도록 해서 다른 방식들보다 일반적으로 적은 용량을 쓰면서도 호환문제가 적은 UTF-8이 전세계적으로 가장 널리 사용된다.

- UTF-8은 어떻게 적은 메모리로 다양한 문자를 표현하는가?

- 유니코드는 거의 세계 모든 언어를 포함하지만, 대부분의 글자는 2Byte(U+0000~U+FFFF)를 사용해야해서, 알파벳 (기존 1byte만을 활용할 수 있었음)을 사용하는 문서에서는 데이터 양이 2배, 많게는 3배가 된다.

- 따라서 UTF-8에서는 2byte 혹은 3byte였던 유니코드에서 어떤 문자는 1byte로, 어떤 문자는 4byte로… 가변적인 길이로 문자를 인코딩한다.

-

가(U+AC00) 를 UTF-8로 인코딩해 보자.- 이것을 이진수로 변환하면

1010110000000000이다. -

AC00은 2바이트 최대 표현 문자 7FF 를 넘기므로, 3바이트 인코딩을 진행한다. (800 ~ FFFF 범위에 있음) - 위에서 나오는 인코딩 표를 참고해 3바이트 인코딩을 진행한다.

- 1110

1010, 10110000, 10000000이 된다. - 따라서

가는 UTF-8로 3바이트이다.

- 이것을 이진수로 변환하면

- 출처: https://velog.io/@goggling/%EC%9C%A0%EB%8B%88%EC%BD%94%EB%93%9C%EC%99%80-UTF-%EC%9D%B4%ED%95%B4%ED%95%98%EA%B8%B0

- 추상화란 무엇인가?

- 추상클래스는 어떤 상황에서 사용하는가?

- 공통 기능을 가지면서 구체적인 구현이 달라야 할 때

- 템플릿 메서드 패턴을 구현할 때

- 여러 클래스가 비슷한 구조를 가지지만 세부 구현이 다를 때

- 공통 메서드와 추상 메서드를 함께 제공하고 싶을 때

- 상속 관계에서 일정한 구조를 강제하고 싶을 때

- 의존성이란 무엇인가?

- 의존성 역전이란 무엇인가?

- 고수준 모듈이 저수준 모듈에 의존하면 안 되고, 둘 다 추상화에 의존해야 한다.

- 의존성 역전 사용 예시

- 코드의 유연성을 높이고 싶을 때

- 테스트하기 쉬운 코드를 만들고 싶을 때

- 외부 라이브러리나 프레임워크 변경에 대비하고 싶을 때

- 다양한 구현체를 갈아끼우고 싶을 때

- 의존성 역전이란 무엇인가?

- 추상클래스는 어떤 상황에서 사용하는가?

의존성 역전

- 의존성 역전 미사용

1

2

3

4

5

6

7

8

9

10

11

12

13

14

# 저수준 모듈

class MySQLDatabase:

def save(self, data):

print(f"MySQL에 저장: {data}")

# 고수준 모듈이 구체적인 클래스에 의존

class UserService:

def __init__(self):

self.db = MySQLDatabase() # 구체 클래스에 직접 의존

def create_user(self, user_data):

# 비즈니스 로직

processed_data = f"처리된 {user_data}"

self.db.save(processed_data)

- 의존성 역전 사용

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

# 추상화 (인터페이스)

class DatabaseInterface(ABC):

@abstractmethod

def save(self, data):

pass

# 저수준 모듈들이 추상화를 구현

class MySQLDatabase(DatabaseInterface):

def save(self, data):

print(f"MySQL에 저장: {data}")

class PostgreSQLDatabase(DatabaseInterface):

def save(self, data):

print(f"PostgreSQL에 저장: {data}")

# 고수준 모듈이 추상화에 의존

class UserService:

def __init__(self, database: DatabaseInterface):

self.db = database # 추상화에 의존

def create_user(self, user_data):

processed_data = f"처리된 {user_data}"

self.db.save(processed_data)

# 사용

mysql_db = MySQLDatabase()

user_service = UserService(mysql_db) # 의존성 주입

select / epoll (socket programming)

- select와 epoll의 차이점

- select

- POSIX 표준이라 크로스 플랫폼 지원 (Linux, macOS, Windows)

- fd_set 구조체를 사용해 파일 디스크립터 집합 관리

- 읽기/쓰기/예외 상황을 각각 다른 집합으로 관리

- 장점

- 호환성: 거의 모든 유닉스 계열 시스템에서 동작

- 단순함: 개념이 직관적이고 사용하기 쉬움

- 작은 규모: 소수의 연결을 다룰 때에는 충분히 효율적

- 단점

- 스케일링 한계: FD_SETSIZE 제한 (보통 1024개)

- 성능 문제: O(n) 복잡도로 모든 fd를 순회해야 함

- 메모리 복사: 매번 커널에 fd_set을 전달해야 함.

- 사용

- 크로스 플랫폼 코드가 필요할 때

- 동시 연결 수가 적을 때 (< 1000)

- 간단한 프로토타입이나 교육 목적

- 임베디드 시스템처럼 리소스가 제한적인 환경

- select로도 1024개가 넘는 연결을 관리할 수 있지만 권장하지 않음.

- 성능 저하: fd가 늘어날수록 선형적으로 느려짐

- 메모리 낭비: fd_set 크기가 커져서 매번 큰 데이터를 복사

- 시스템 한계: 일부 시스템에서는 FD_SETSIZE 변경이 제대로 동작하지 않을 수 있음

- 버그 위험: 라이브러리들이 기본 FD_SETSIZE를 가정하고 만들어져 있어 충돌 가능

1 2 3 4 5 6 7 8 9 10 11

// select가 O(n) 인 이유 // 전체 중에서 활성인 것 찾기 (탐색 필요) // [fd1][fd2][fd3]...[fd1000] -> 전체 스캔해서 체크 // select는 매번 이런 일을 해야 함 for(int fd = 0; fd <= max_fd; fd++) { if(FD_ISSET(fd, &readfds)) { // 활성 fd 찾으려면 모든 fd를 다 확인해야 함 handle_event(fd); } } // -> fd 개수에 비례해서 시간 걸림 (O(n))

- epoll

- Linux 전용 (커널 2.6부터)

- 이벤트 기반 I/O 알림

- Edge-triggered와 Level-triggered 모드 지원

- Edge-triggered

- “변화”를 알려줌.

- 새로운 데이터가 도착했을 때만 알림

- 한 번 알림 받으면 모든 데이터를 다 읽어야 함.

- 성능이 좋지만, 구현이 까다로움. 모든 데이터를 다 처리해야 함.

- Level-triggered

- “상태”를 알려줌.

- 데이터가 있는 동안 계속 알림

- 일부만 읽어도 다음 epoll_wait에서 또 알림 받음

- 구현이 쉽고 안전함. 실수해도 데이터를 안 잃어버림.

- Edge-triggered

- 장점

- 확장성: 수만 개의 연결도 효율적으로 처리

- 성능: O(1) 복잡도로 활성 이벤트만 반환

- 메모리 효율: 커널이 이벤트 테이블을 관리해서 중복 복사 없음

- 유연성: ET/LT 모드 선택 가능

- 단점

- 플랫폼 종속: Linux에서만 동작

- 복잡성: 개념이 좀 더 복잡하고 실수하기 쉬움

- 사용 사례

- 고성능이 필요한 서버 (nginx, Redis 등)

- 동시 연결 수가 많을 때 (> 1000)

- Linux 환경에서만 동작해도 될 때

- C10K 문제를 해결해야 할 때

- C10K = “10,000개 동시 연결”을 뜻함

- 1990년대 말 ~ 2000년대 초의 문제

- 웹 서버가 동시에 10,000명의 클라이언트를 처리하지 못함.

- 하드웨어는 충분했는데 소프트웨어 아키텍쳐가 문제

- 해결책: epoll, kqueue, IOCP, 비동기 I/O

1 2 3 4 5 6 7 8 9 10 11 12

// epoll이 O(1) 인 이유 // 활성인 것만 알려주기 (커널이 미리 준비) // 커널 이벤트 테이블 -> [활성_fd만] -> 유저에게 전달 // epoll은 커널이 미리 준비해둠 struct epoll_event events[MAX_EVENTS]; int ready = epoll_wait(epfd, events, MAX_EVENTS, -1); // 활성 이벤트만 바로 받아서 처리 for(int i = 0; i < ready; i++) { handle_event(&events[i]); // 이미 활성화된 것만 받음 } // -> 활성 이벤트 개수에만 비례 (보통 O(1)에 가까움)

- Apache 웹서버와 Nginx 웹서버

- Apache (아파치) 웹서버

- prefork MPM 또는 worker MPM 사용

- (MPM = Multi-Processing Module)

- 아파치 웹서버에서 여러 요청을 어떻게 처리할 것인가를 결정하는 모듈

- (MPM = Multi-Processing Module)

- prefork MPM

- 각 요청마다 별도의 프로세스

- 안정적이지만 메모리 많이 먹음

- select/poll 안 써도 됨. (각 프로세스가 하나씩만 처리)

- 2000~4000 동시 연결

- worker MPM

- 스레드 풀 사용

- prefork보다 메모리 효율적

- event MPM

- 이벤트 기반

- Apache 2.4 부터 기본

- epoll/kqueue 사용

- Keep-Alive 연결을 효율적으로 관리

- ~10000+ 동시 연결 (nginx와 비슷한 성능)

- prefork MPM 또는 worker MPM 사용

- Apache (아파치) 웹서버

- Nginx 웹서버

- 처음부터 이벤트 기반 아키텍쳐로 설계됨.

- ~ 50000+ 동시 연결

- 메모리 효율적

- 현재는 Apache도 event MPM으로 epoll을 사용할 수 있어 성능 차이가 예전만큼 크지 않음.

- 그러나 nginx가 처음부터 이벤트 기반으로 설계되어 있어 좀 더 최적화되어 있긴 하다.

cloud

- object storage

- 객체(object) 단위로 저장하는 스토리지 방식

- 기존의 파일 시스템이나 블록 스토리지와는 다른 접근법

- 핵심 개념

- 객체 구조

- 데이터: 실제 파일 내용(이미지, 동영상, 문서 등)

- 메타데이터: 파일 정보(생성일, 크기, 타입 등)

- 고유 ID: 각 객체를 식별하는 Unique key

- 플랫 구조

- 전통적인 폴더/디렉토리 계층 구조 없음

- 모든 객체가 “버킷(Bucket)” 안에 플랫하게 저장됨.

- 버킷: Object Storage에서 가장 상위 단위의 컨테이너 (큰 상자같은 개념)

- 전통적인 방식:

/home/user/documents/photos/2024/cat.jpg - 버킷 방식:

my-bucket/cat.jpg,my-bucket/my-company-backup-2024…

- 전통적인 방식:

- 버킷: Object Storage에서 가장 상위 단위의 컨테이너 (큰 상자같은 개념)

- URL같은 고유 주소로 접근함.

- 객체 구조

- 장점

- 확장성

- 사실상 무제한 용량

- 필요한 만큼 자동으로 확장

- 내구성

- 여러 데이터센터에 복제해서 저장

- 99.99.999999999% (11.9’s) 내구성 보장

- 다중 복제 (기본 3-way 복제)

- 단일 디스크 고장률: 1% (연간)

- 3개 복제본이 모두 동시에 망가질 확률: 0.01**3 = 0.000001 (0.0001%)

- 지리적 분산

- 서로 다른 데이터센터에 복제본 저장

- 자연재해, 정전 등 지역적 장애 대응

- AWS는 최소 3개의 가용영역(AZ)에 분산

- 에러 감지 및 자동 복구

- 체크섬 검증

- 데이터 읽을 때마다 무결성 검사

- 손상 감지 시 다른 복제본에서 자동 복구

- 백그라운드에서 지속적인 데이터 스크리밍

- 체크섬 검증

- 하드웨어 중복성

- RAID 구성으로 디스크 레벨 보호

- 이중화된 전원, 네트워크

- 서버 레벨 중복성

- 다중 복제 (기본 3-way 복제)

- 접근성

- HTTP REST API로 어디서든 접근 가능

- 웹에서 직접 파일 서빙 가능

- 확장성

- 주요 클라우드 서비스들

- AWS S3 (Simple Storage Service)

- Google Cloud Storage

- Azure Blob Storage

- 네이버 클라우드 Object Storage

- 언제 쓰면 좋을까?

- 정적 웹사이트 호스팅

- 백업 및 아카이빙

- 빅데이터 저장

- CDN 원본 스토리지

- 이미지/동영상 같은 미디어 파일 저장

- 배경

- 전통적인 스토리지의 한계

- 파일 시스템 (NFS, CIFS)의 문제점

- 계층적 폴더 구조로 인한 복잡성

- 단일 서버 의존성 -> 확장이 어려움

- 네트워크 지연에 민감

- 블록 스토리지(SAN)의 문제점

- 설정과 관리가 너무 복잡

- 하드웨어 비용이 엄청남

- 확장할 때마다 큰 투자 필요

- 웹의 폭발적 성장

- 새로운 요구사항들

- 전 세계 어디서든 빠른 접근 필요

- 이미지, 동영상 같은 멀티미디어 급증

- 사용자 생성 콘텐츠 폭증(Youtube, Flickr 등)

- 아마존의 현실적 문제

- 전 세계 이커머스 운영

- 수백만 개의 상품 이미지 저장/서빙 필요

- 피크 시즌 (블랙프라이데이) 트래픽 급증

- 새로운 요구사항들

- 클라우드 컴퓨팅의 필요성

- 아마존이 S3를 만든 이유(2006년)

- 자체 인프라 문제 해결이 목적

- “무제한 확장 가능 스토리지” 필요

- API를 통한 프로그래밍 방식 접근

- 아마존이 S3를 만든 이유(2006년)

- 빅데이터 시대의 도래

- 데이터 폭증

- 로그 파일, 센서 데이터 급증

- 비정형 데이터(이미지, 동영상, 문서) 증가

- 정형 데이터

- 미리 정의된 스키마(구조)가 있음.

- 행과 열로 깔끔하게 정리됨.

- 데이터 타입이 명확함

- SQL로 쉽게 검색/분석 가능

- 비정형 데이터

- 미리 정의된 구조가 없음

- 각 파일마다 형태가 다름

- 내용을 이해하려면 특별한 처리 필요

- 크기가 매우 다양함

- 정형 데이터

- 기존 DB로는 비용/성능 한계

- 데이터 폭증

- REST API와 HTTP의 성숙

- 웹 표준 활용

- HTTP/REST API를 통한 단순한 접근

- 기존 웹 기술과 자연스러운 통합

- 개발자들이 쉽게 사용 가능

- 웹 표준 활용

- 전통적인 스토리지의 한계

- 파일시스템과 네트워크 파일 시스템

- SAN?

- 분산 파일 시스템(HDFS, Ceph)

- 실시간 공동 편집 기술

- 파일 블록이란?

- 파일을 어떻게 디스크에 저장하는가? 어떤 블록 단위로 쪼개져 저장하는가?

- IaaS (Infrastructure as a Service)

- 가상의 컴퓨터를 빌려주는 서비스

- 제공하는 것

- 가상 서버(CPU, Memory, Storage)

- 네트워크 설정

- 기본 하드웨어 인프라

- 해야할 일

- 운영체제 설치/관리

- 미들웨어 설치(DB, 웹서버 등)

- 애플리케이션 개발/배포

- 보안 패치, 백업 등

- Example

- AWS EC, Google Computer Engine, Azure VM

- 빈 컴퓨터 한대 줌. 나머진 니가 다 해

- PaaS (Platform as a Service)

- 개발 플랫폼을 통째로 제공하는 서비스

- 제공하는 것

- IaaS + 운영체제 + 런타임 환경

- 데이터베이스, 웹서버 등 미들웨어

- 개발/배포 도구

- 해야할 일

- 애플리케이션 코드만 작성

- 배포 (보통 git push 수준)

- Example

- Heroku, Google App Engine, Azure App Service

- 코드만 올려, 나머진 우리가 다 해줌.

- SaaS (Software as a Service)

- Software as a Service

- 제공하는 것

- 완전히 동작하는 애플리케이션

- 모든 인프라 + 플랫폼 + 소프트웨어

- 해야할 일

- 그냥 사용하기만 하면 됨

- 설정 정도만 변경

- Example

- Gmail, Notion, Slack, Salesforce

- 이미 다 만들어진 서비스임. 그냥 써라.

- 그럼 Object Storage는 IaaS인가 SaaS인가?

- 인프라스트럭쳐 레벨의 기본 구성 요소(Storage 대여)

- 다른 서비스들이 위에 올라가는 기반

- 개발자가 직접 통합해서 사용해야 함.

- 그러나 완전 관리형이라는 특성 때문에 전통적인 IaaS(서버 관리)와는 조금 다른 느낌.

- 그래서 요즘에는 Storage as a Service 라고 따로 부르는 추세임.

- StaaS: Storage as a Service

- 저장소만 딱 떼어서 서비스로 제공

- 전통적인 서버: CPU + Memory + 스토리지 + 네트워크 (묶음 패키지)

StaaS: 스토리지만 독립적으로 제공

- Object Storage

- AWS S3

- Google Cloud Storage

- Azure Blob Storage

- 네이버 클라우드 Object Storage

- HTTP API로 파일 저장/조회

- Block Storage